If you are looking for an English version of this article, please visit here.

İÇİNDEKİLER

Başlangıç

2024 yılının Mayıs ayı itibariyle üretken yapay zekanın devrimine, gelişimine hem heyecanla hem de endişeyle tanıklık etmeye devam ediyoruz. OpenAI firması, duyurduğu GPT-4o ile ChatGPT‘nin insana çok daha yakın şekilde diyalog kurduğunu, ses, metin ve görüntüyü anlayıp, içerik ürettiğini bir lansmanla dünyaya gösterdi. Öte yandan yapay zeka savaşlarında geride kalmak istemeyen Google ise OpenAI’nın hemen ardından kendi üretken yapay zekası Gemini’den yeni bir özellik paylaştı. Bu özellik ile Gemini, kamera uygulaması üzerinden çevrede neler olup bittiğini, konum olarak nerede olduğunu kullanıcıya anlık olarak aktarabiliyordu.

Peki büyük bir heyecanla, merakla takip ettiğimiz bu gelişmelerin yanında biz siber güvenlik profesyonellerini, araştırmacılarını en çok ne endişelendirir diye soracak olursak, kendi adıma sunulan tüm bu özelliklerin dolandırıcıların, tehdit aktörlerinin gerçekleştirecekleri dolandırıcılık girişimlerini, siber saldırıları ne kadar kolaylaştırdığı veya zorlaştırdığı olur. İnsansı robotlarda olduğu gibi üretken yapay zekada da gelişim, insan, insana yakın üretkenlikle kıyaslandığı için de genelde ortaya çıkan faydadan art niyetli kişiler de başta derin sahte, diğer orijinal adıyla deepfake ile görsel, video, ses ve metin oluşturma noktasında fazlasıyla nemalanıyorlar. OpenAI CEO’su Sam ALTMAN da benimle aynı fikirde olsa gerek ki geçtiğimiz günlerde Open AI’nın DALL-E 3 modeli ile oluşturulan deepfake görsellerinin tespit edilmesi için bir araç üzerinde çalıştıklarını duyurdu.

Deepfake Nedir?

Deepfake, mevcut bir görüntü veya videoda yer alan bir kişinin, yapay sinir ağları kullanarak bir başka kişinin görüntüsü ile değiştirildiği bir medya türüdür. Sıklıkla, otomatik kodlayıcılar ve çekişmeli üretici ağlar (GAN’lar) olarak bilinen makine öğrenme tekniklerini kullanarak mevcut medyanın kaynak medya üzerinde birleştirilmesi ve üst üste konması ile üretilirler. (Kaynak: Wikipedia)

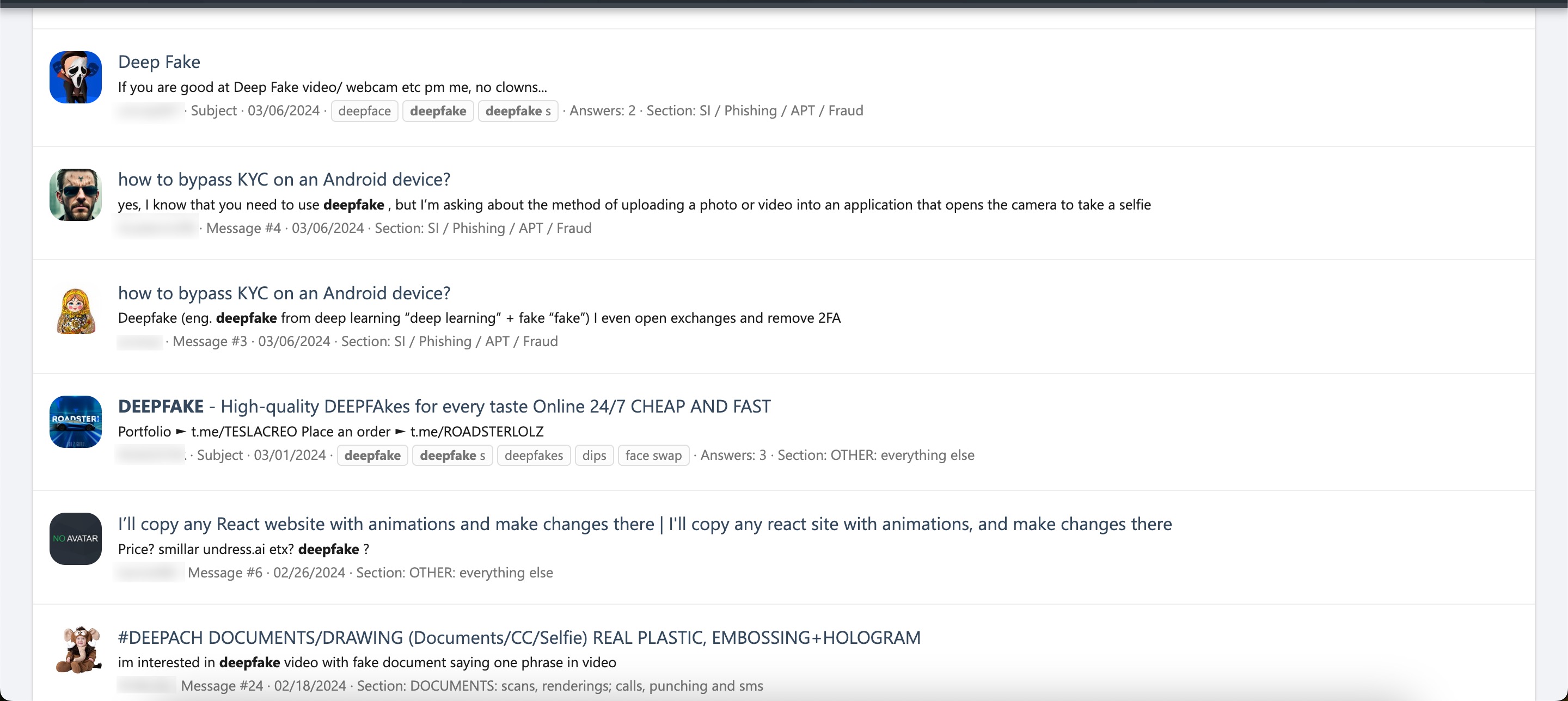

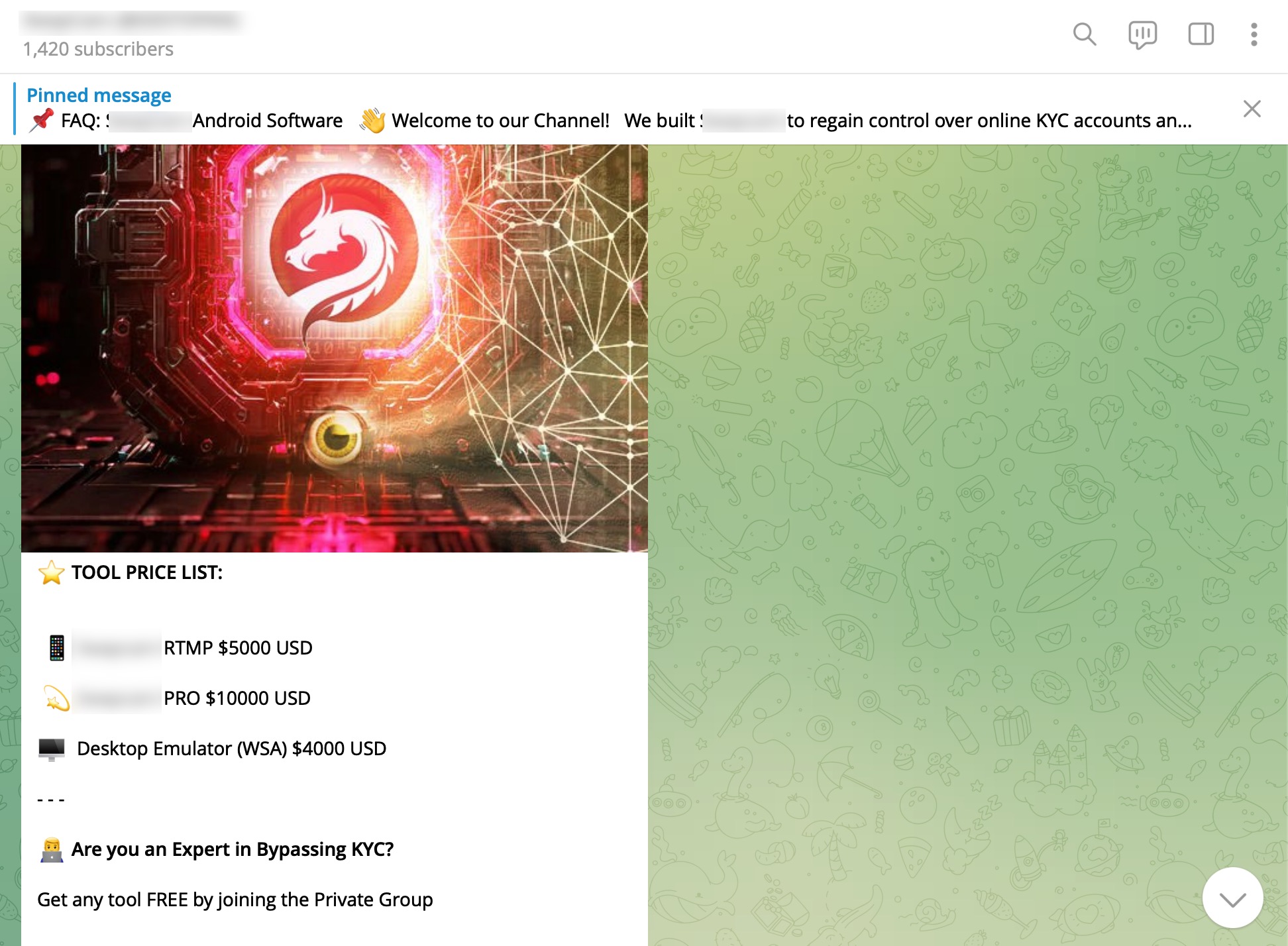

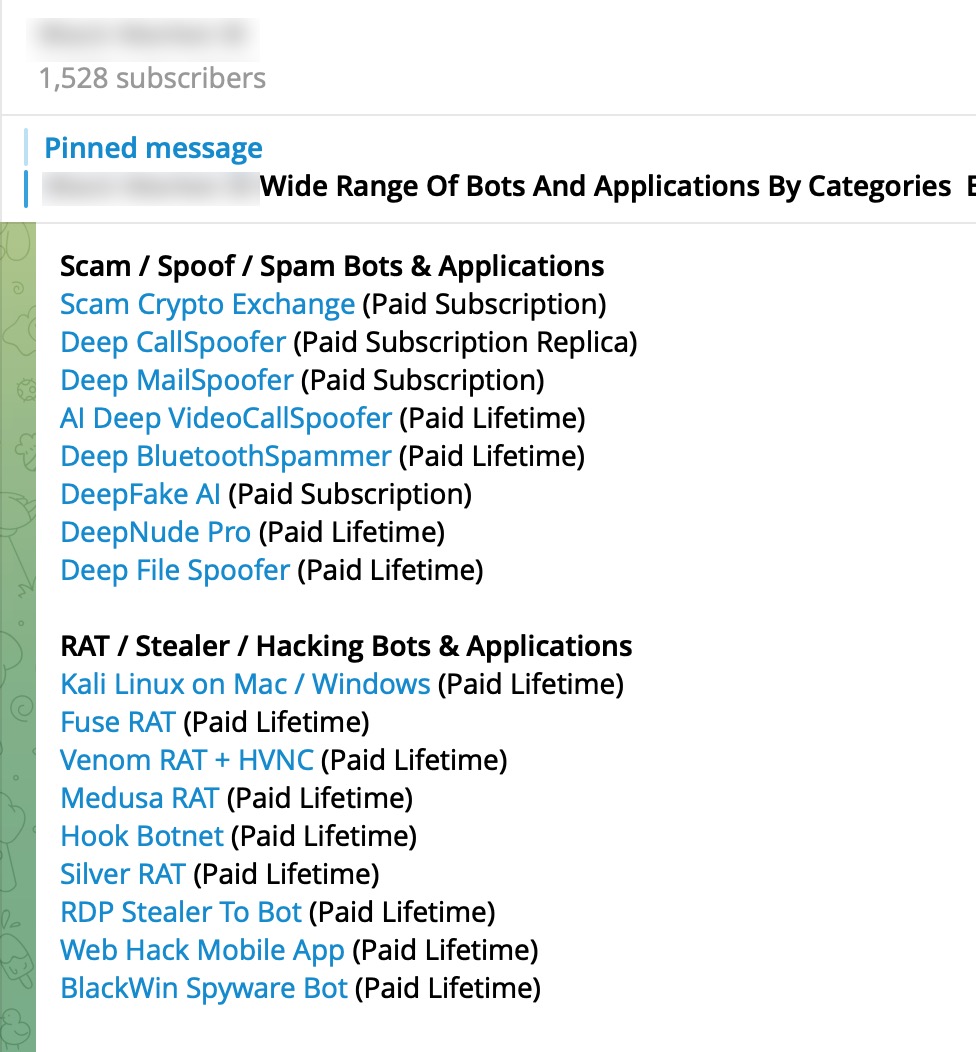

Deepfake’nin son yıllarda başta Rusya – Ukrayna savaşı olmak üzere dezenformasyon, dolandırıcılık ve parodi amacıyla sıklıkla kullanıldığını görüyoruz. Diğer yandan dolandırıcıların, tehdit aktörlerinin sıklıkla yer aldığı forumlara, Telegram kanallarına göz attığımızda da deepfake üzerine paylaşılan mesajların, dolandırıcılık servislerinin arttığı da dikkatlerden kaçmıyor. Pek tabii bu artış, sosyal ağlarda zaman geçiren kişilerin bu tür dolandırıcılık risklerine maruz kalma ihtimalini de bir o kadar arttırıyor.

Deepfake Çetesi

SOCRadar gibi tehdit aktörlerinin, dolandırıcıların izini süren ve müşterilerine bu konuda 7/24 istihbarat sağlayan bir siber tehdit istihbaratı firmasında çalışıyor veya hizmet alıyorsanız öyle ya da böyle çok sayıda farklı mecrada art niyetli kişiler tarafından gerçekleştirilen şüpheli, zararlı aktiviteleri yakından takip etme, haberdar olma imkanınız oluyor.

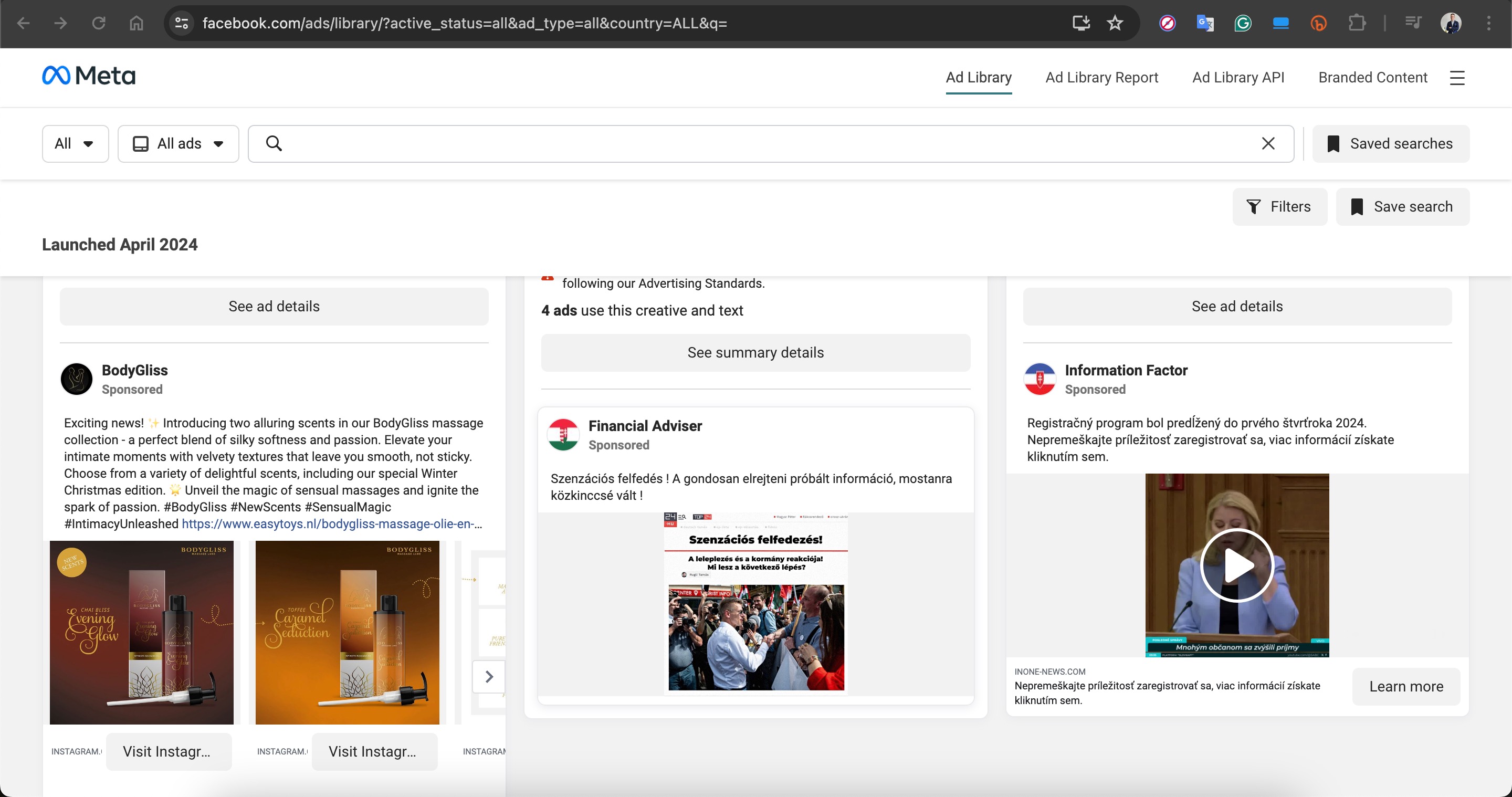

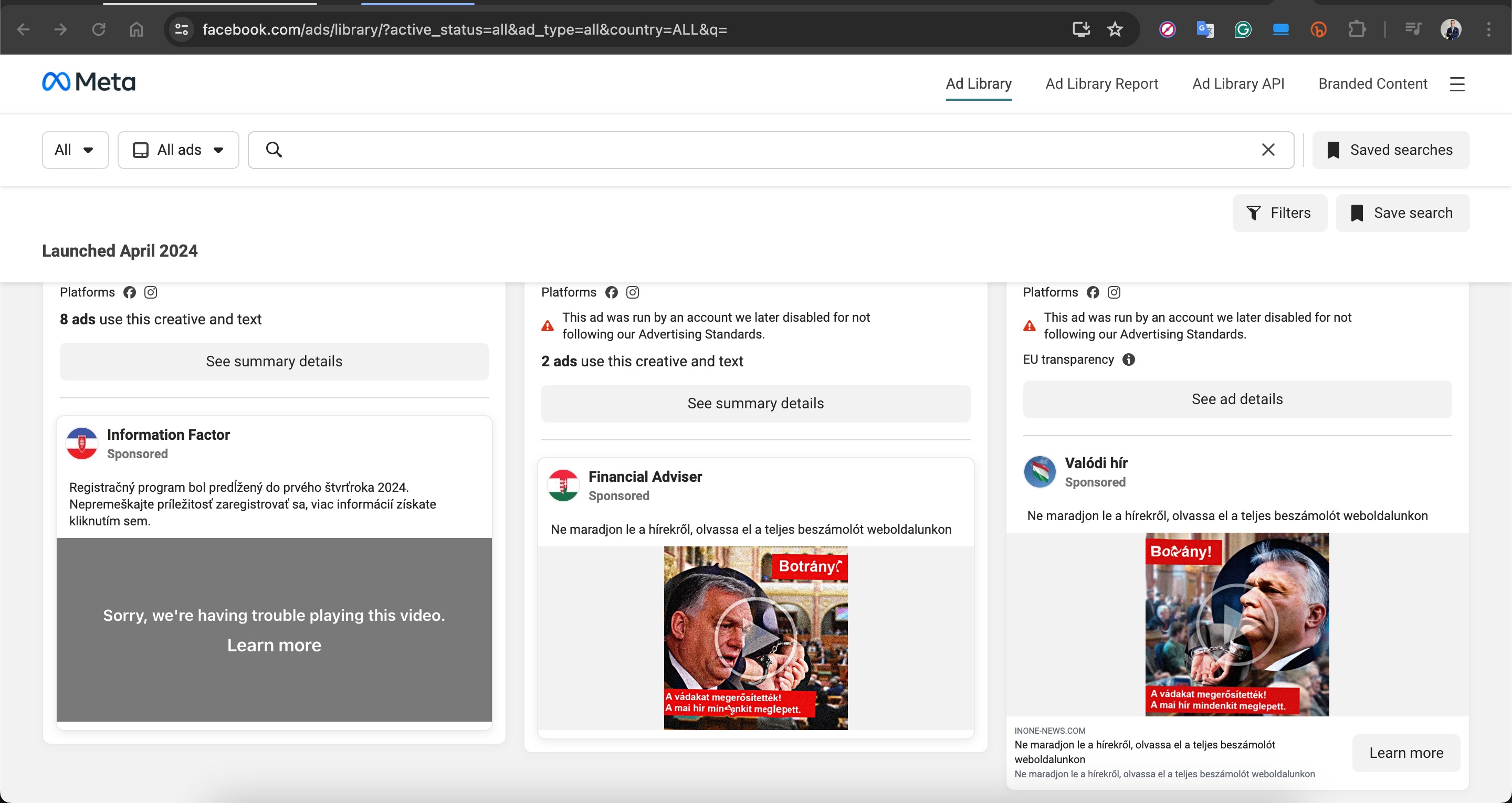

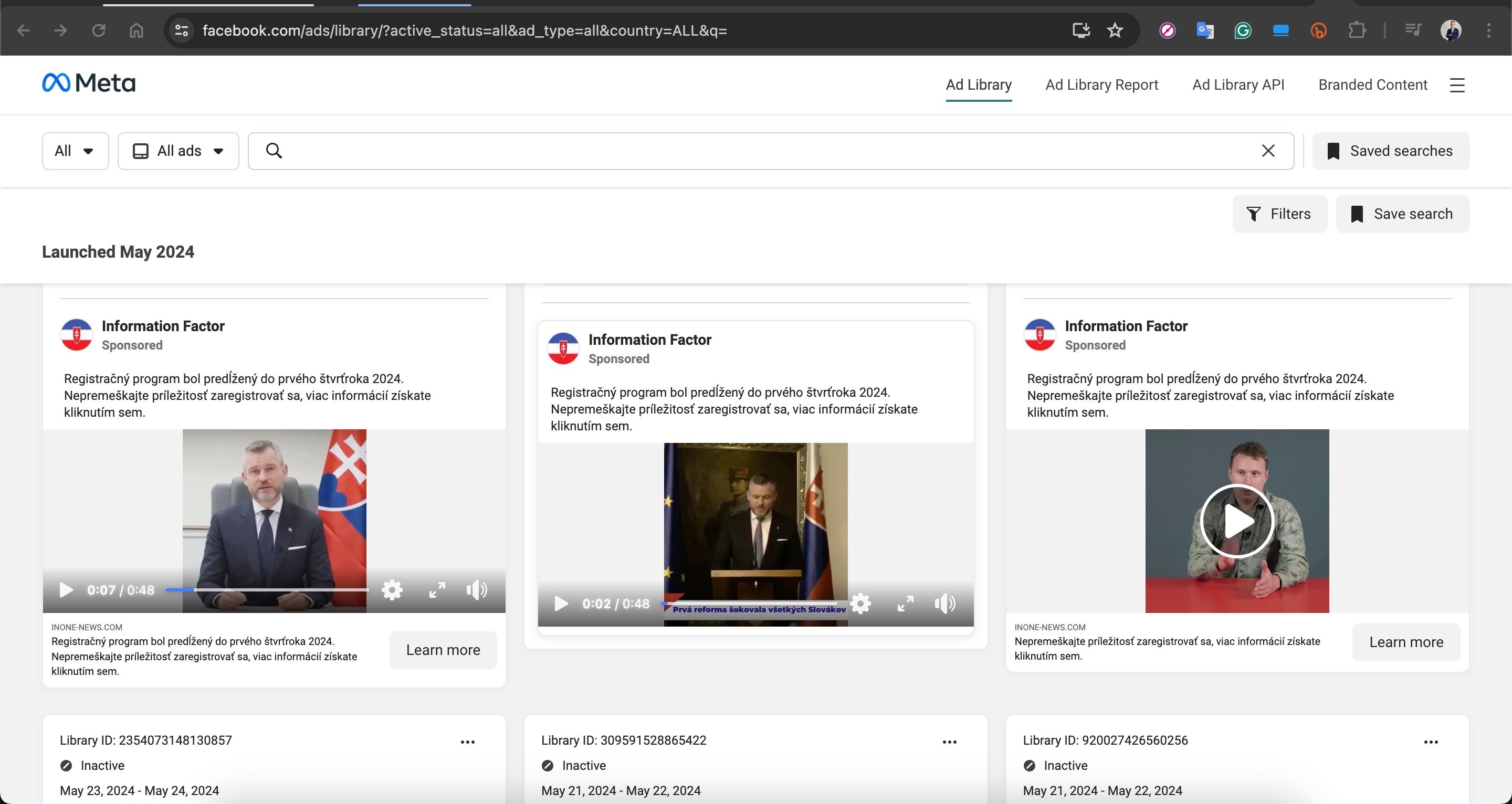

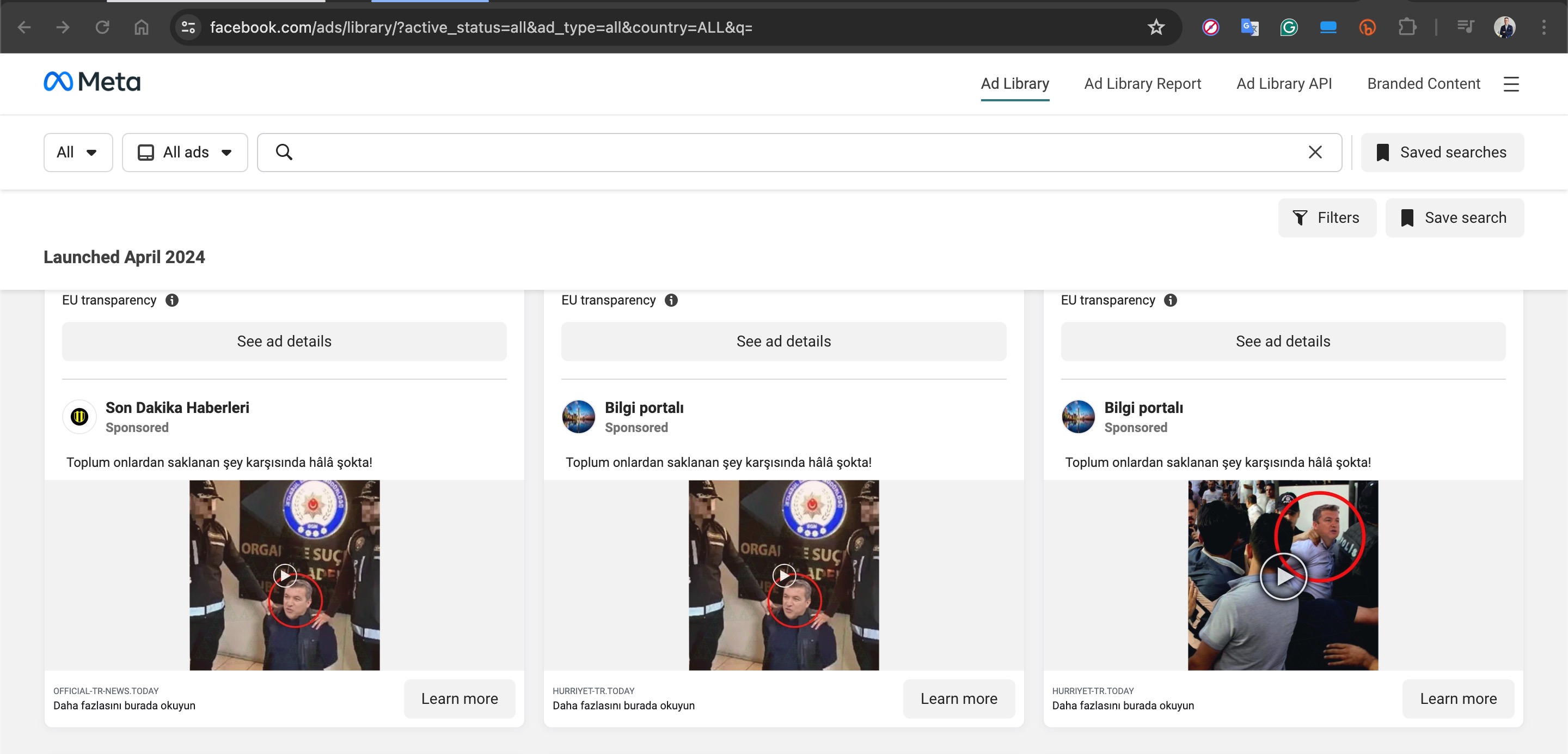

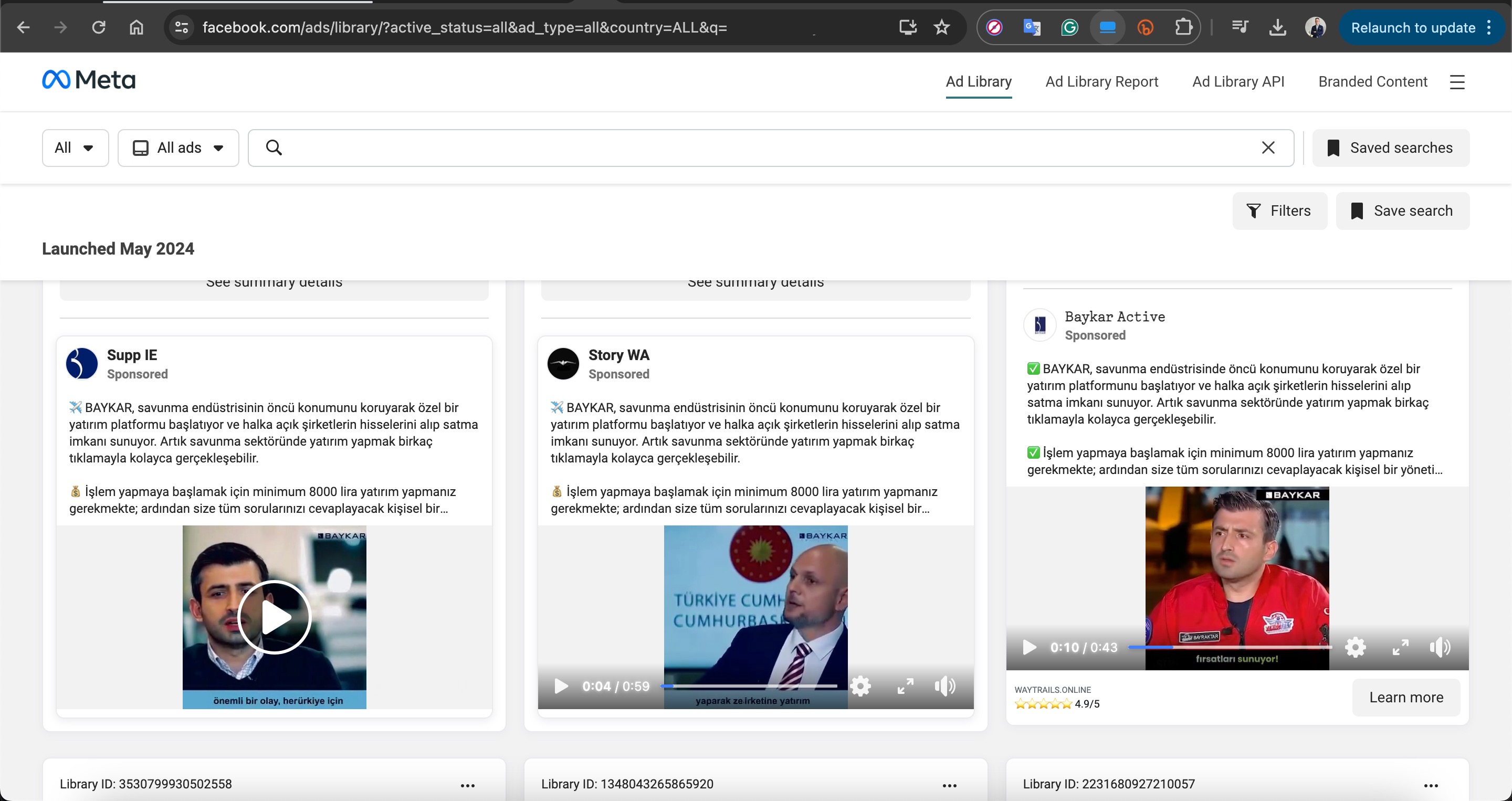

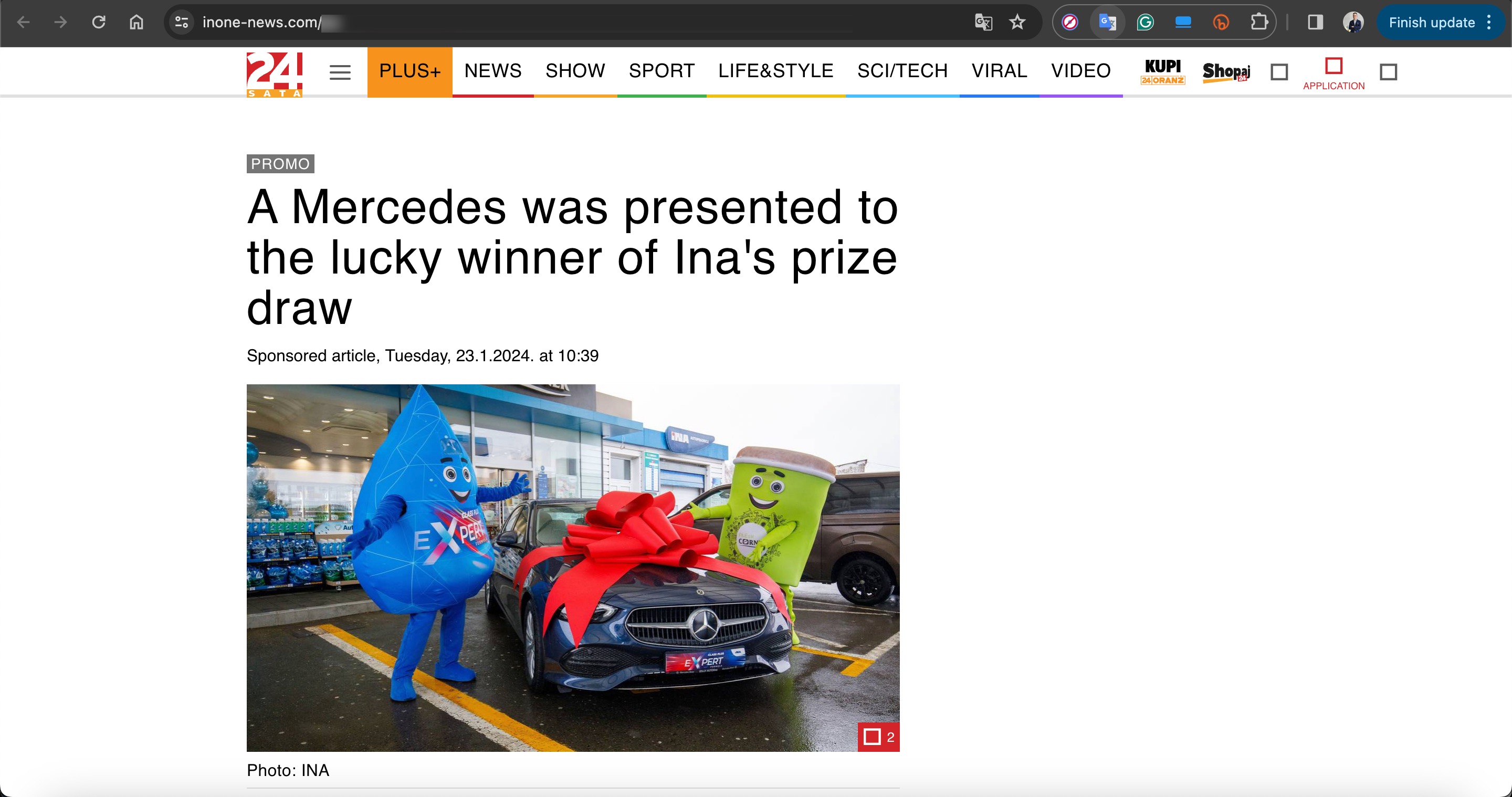

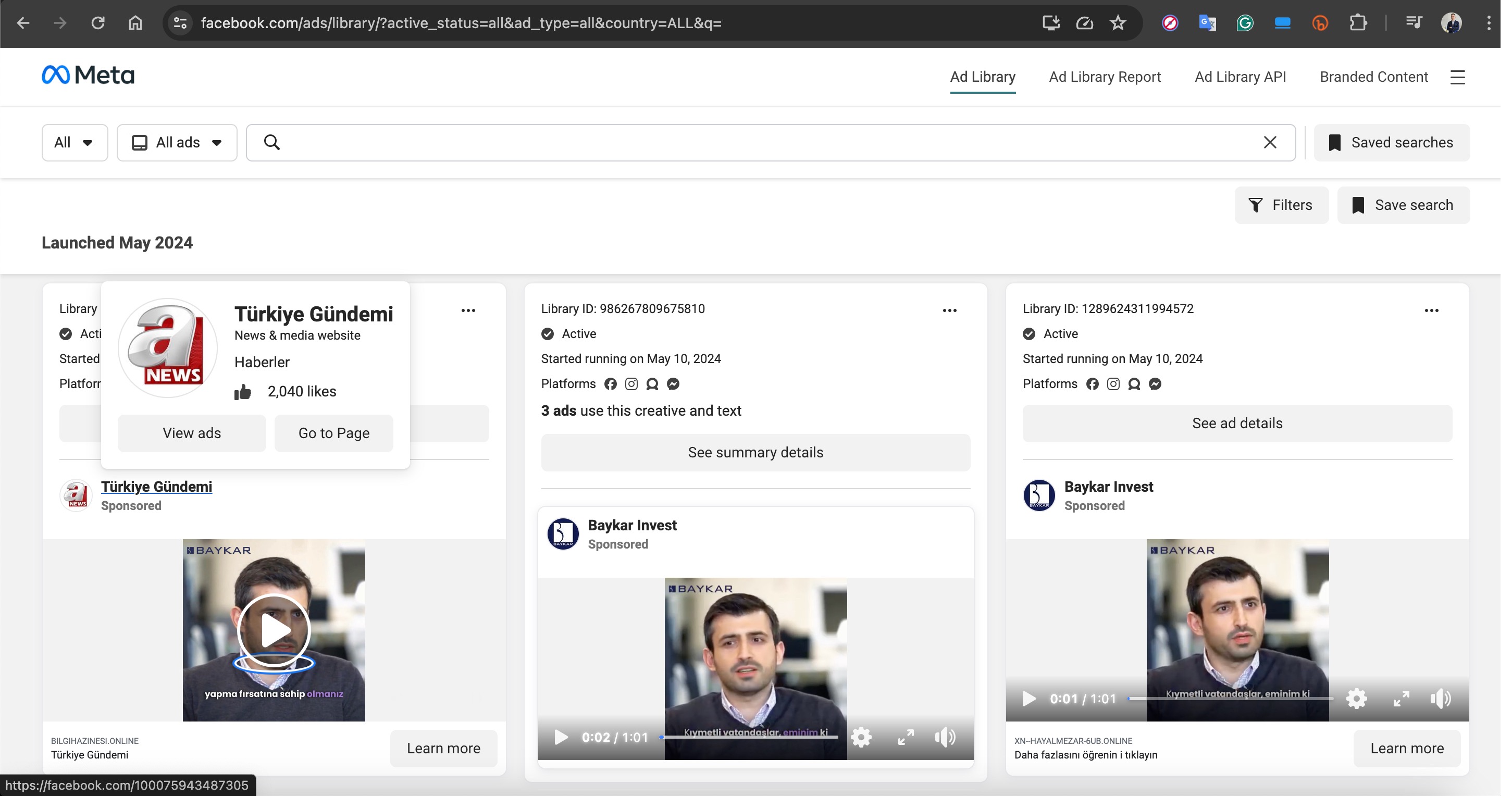

Yakın bir süre önce elde ettiğim bilgiler doğrultusunda Rusya merkezli olduğuna kanaat getirdiğim, operasyonlarının teknik detaylarına başka bir yazımda yer vermeyi planladığım bir dolandırıcılık çetesini yakından takip etmeye başladım. 2023 yılının Ekim ayından bu yana Slovnaft, INA d.d, Bosphorus Gaz gibi petrol rafineri, gaz dağıtım şirketlerinden, Baykar gibi savunma şirketlerine hatta Interpol‘e kadar uluslararası kurumların adını kullanarak dolandırıcılık girişiminde bulunan bu çete, Meta çatı şirketine ait Facebook, Instagram, Messenger üzerinden sahte reklamlarla kurbanlarını avlamaya çalışıyordu. Zaman zaman Google arama sayfasına da sahte reklam veren bu çete özellikle hedef aldıkları ülkelerin vatandaşlarını ağlarına düşürmek için siyasetçilere, iş insanlarına, haber sunucularına ait deepfake ile oluşturulmuş görseller, videolar kullanmaktan da geri kalmıyorlardı.

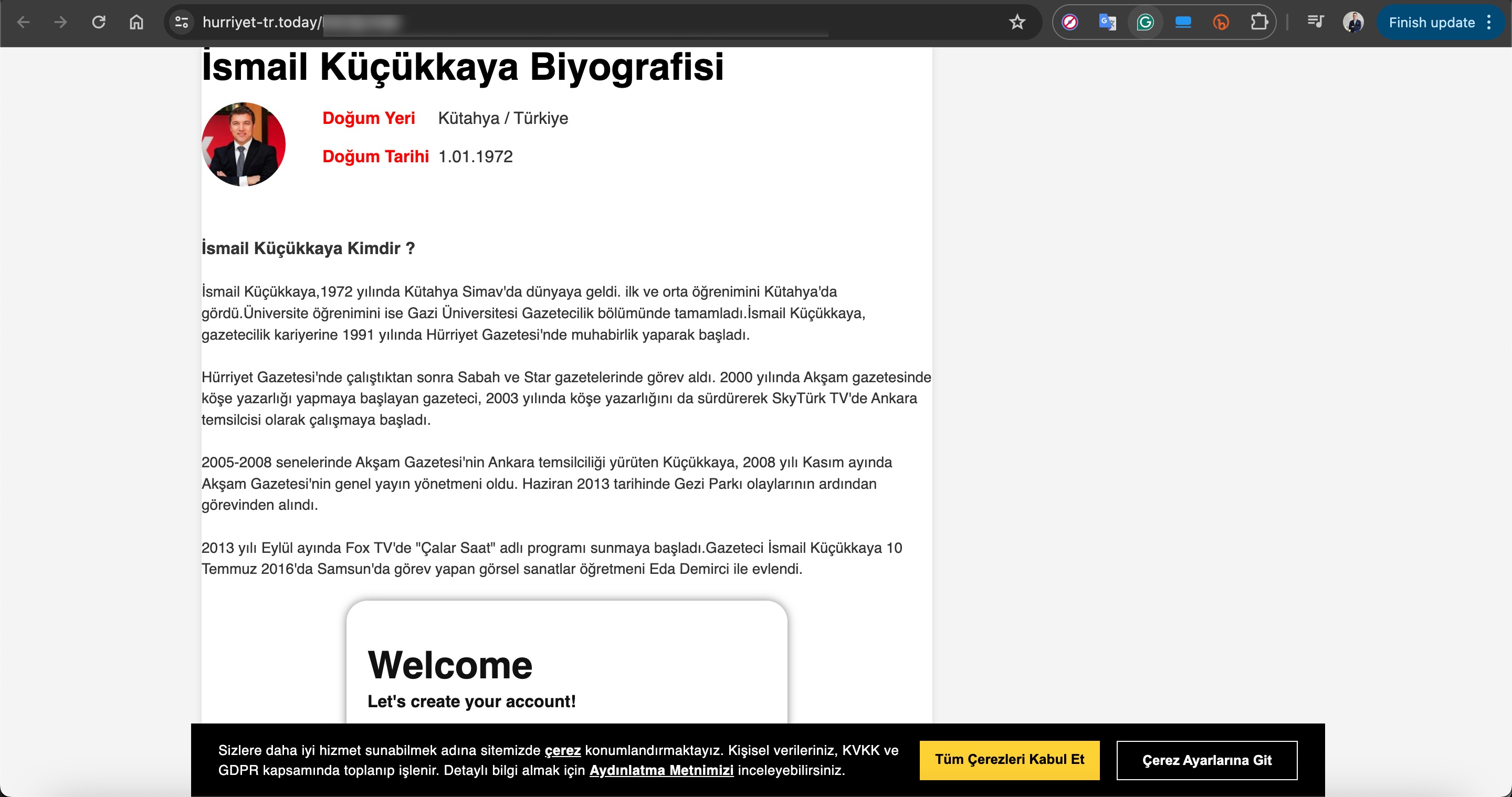

Örneğin Türk vatandaşlarını hedef aldıkları reklamlarında Selçuk BAYRAKTAR, Acun ILICALI, İsmail KÜÇÜKKAYA gibi isimlerin deepfake görsellerini ve videolarını kullanıyorlardı.

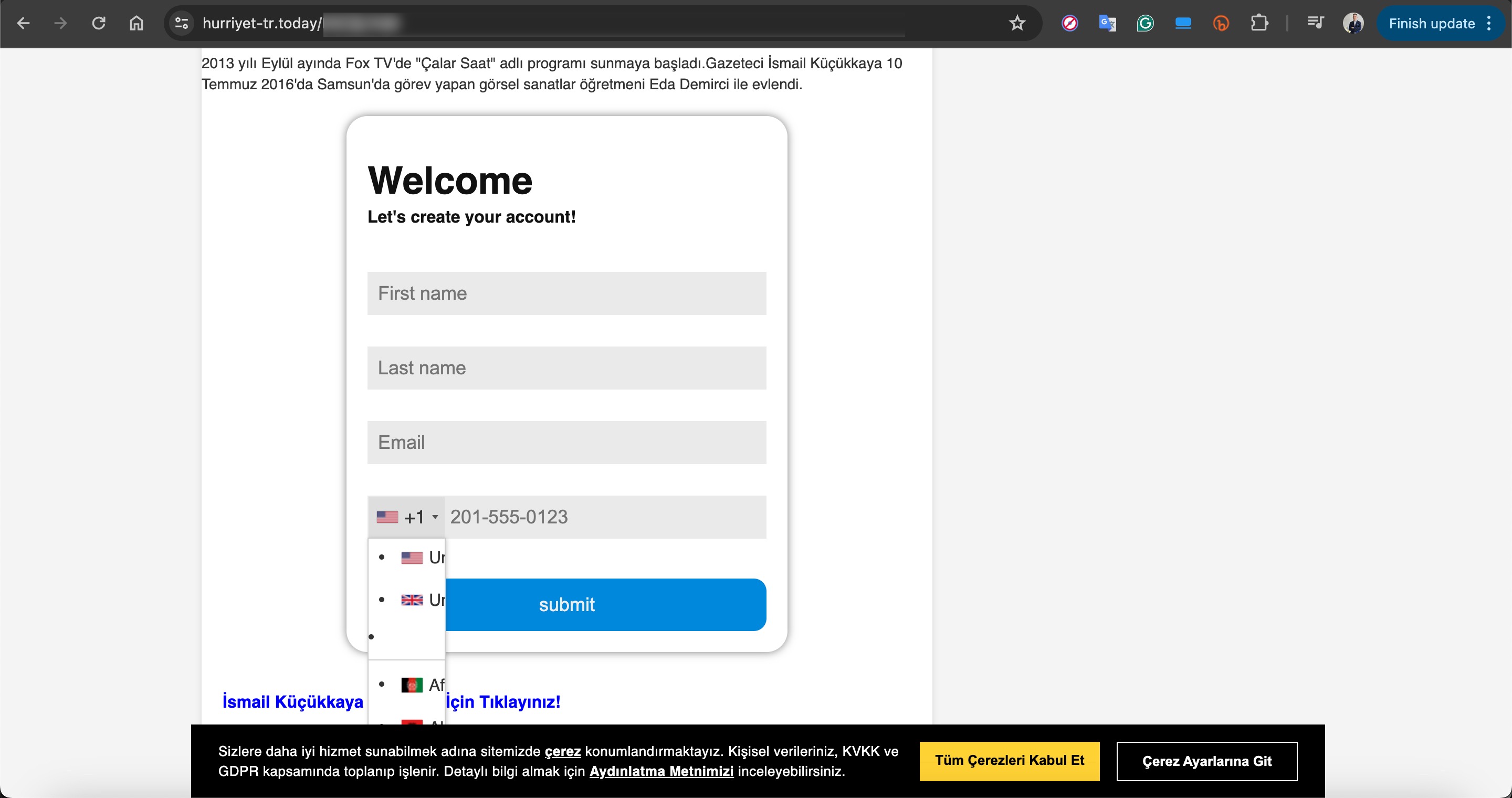

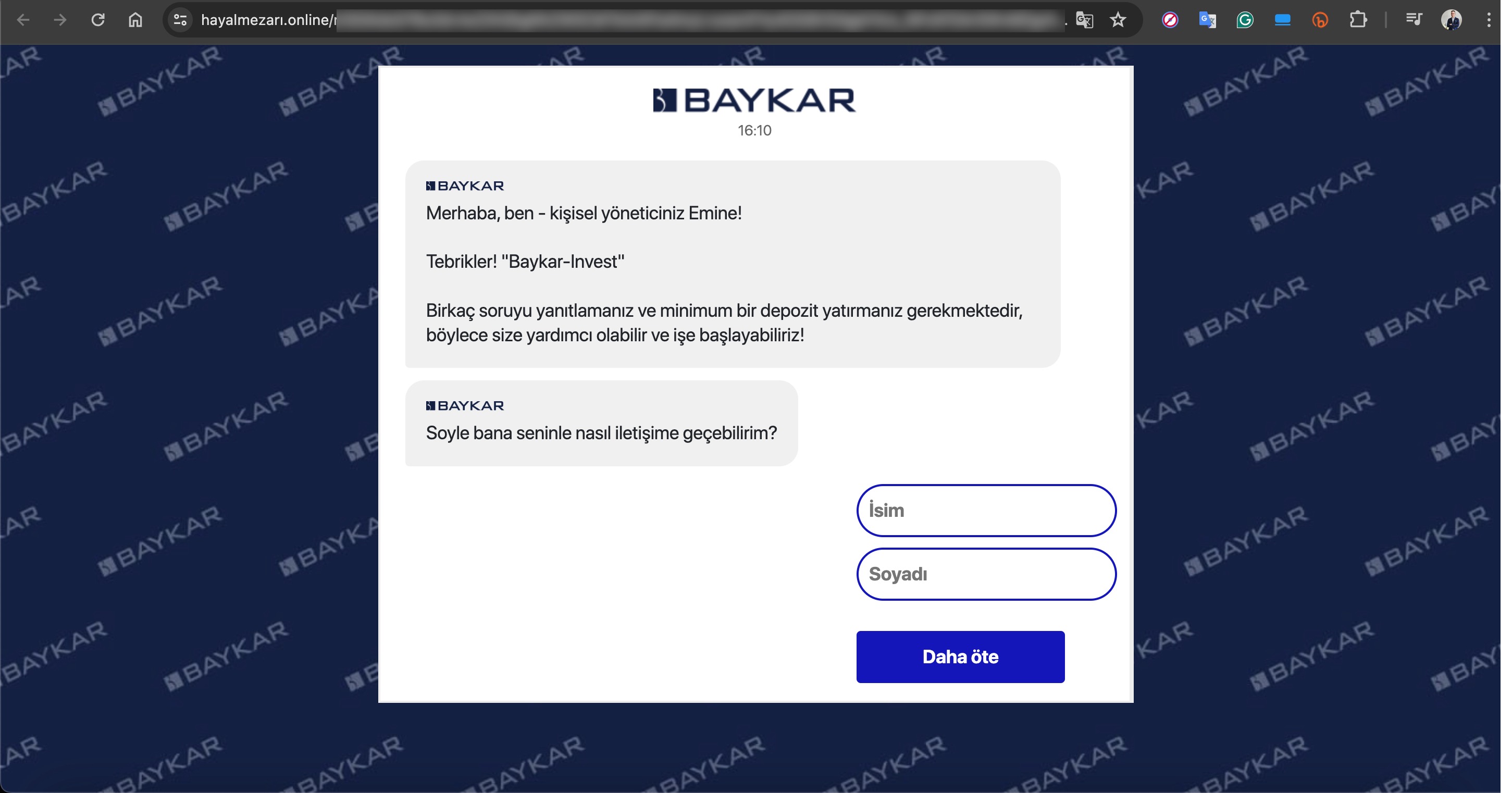

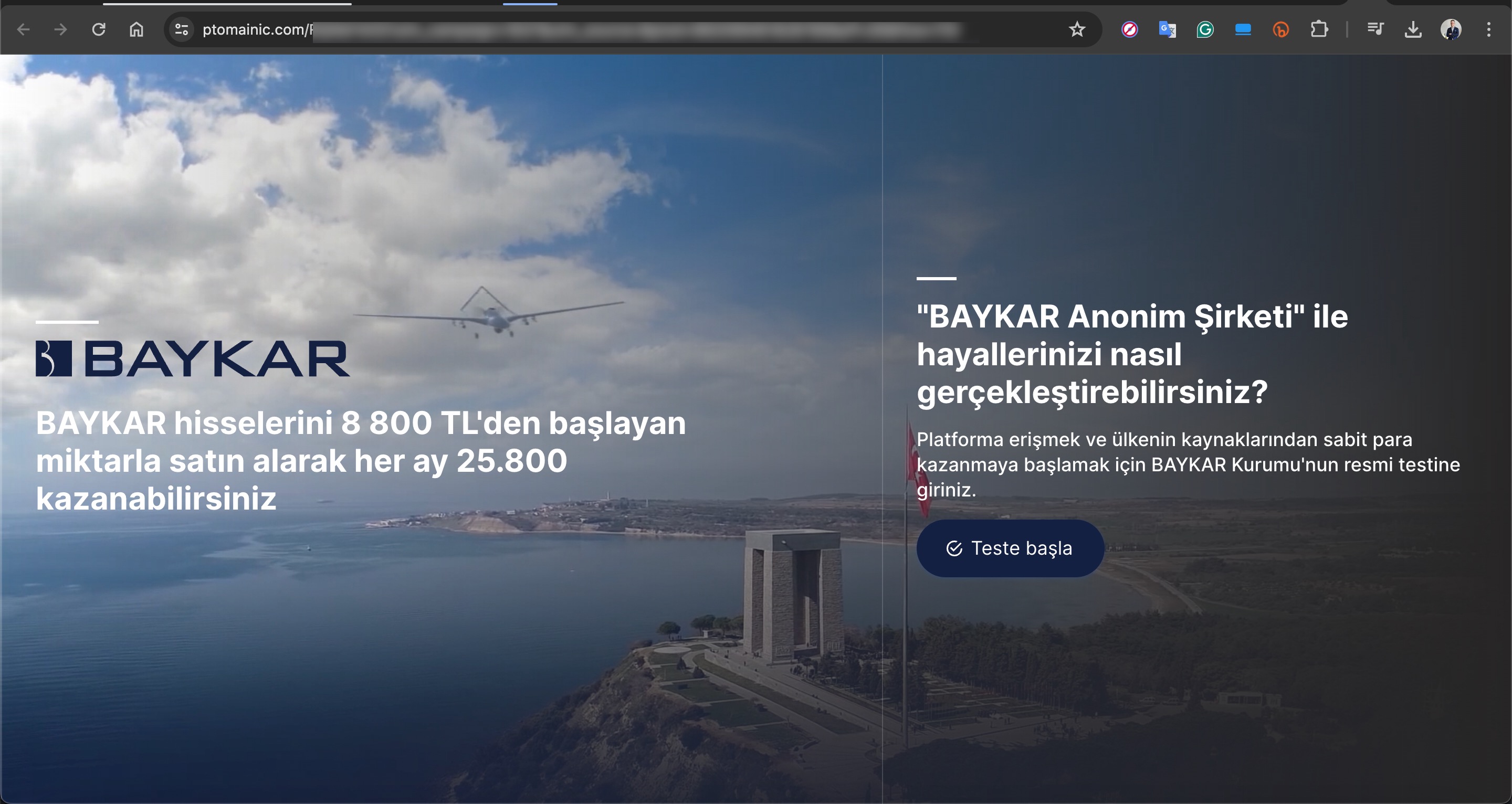

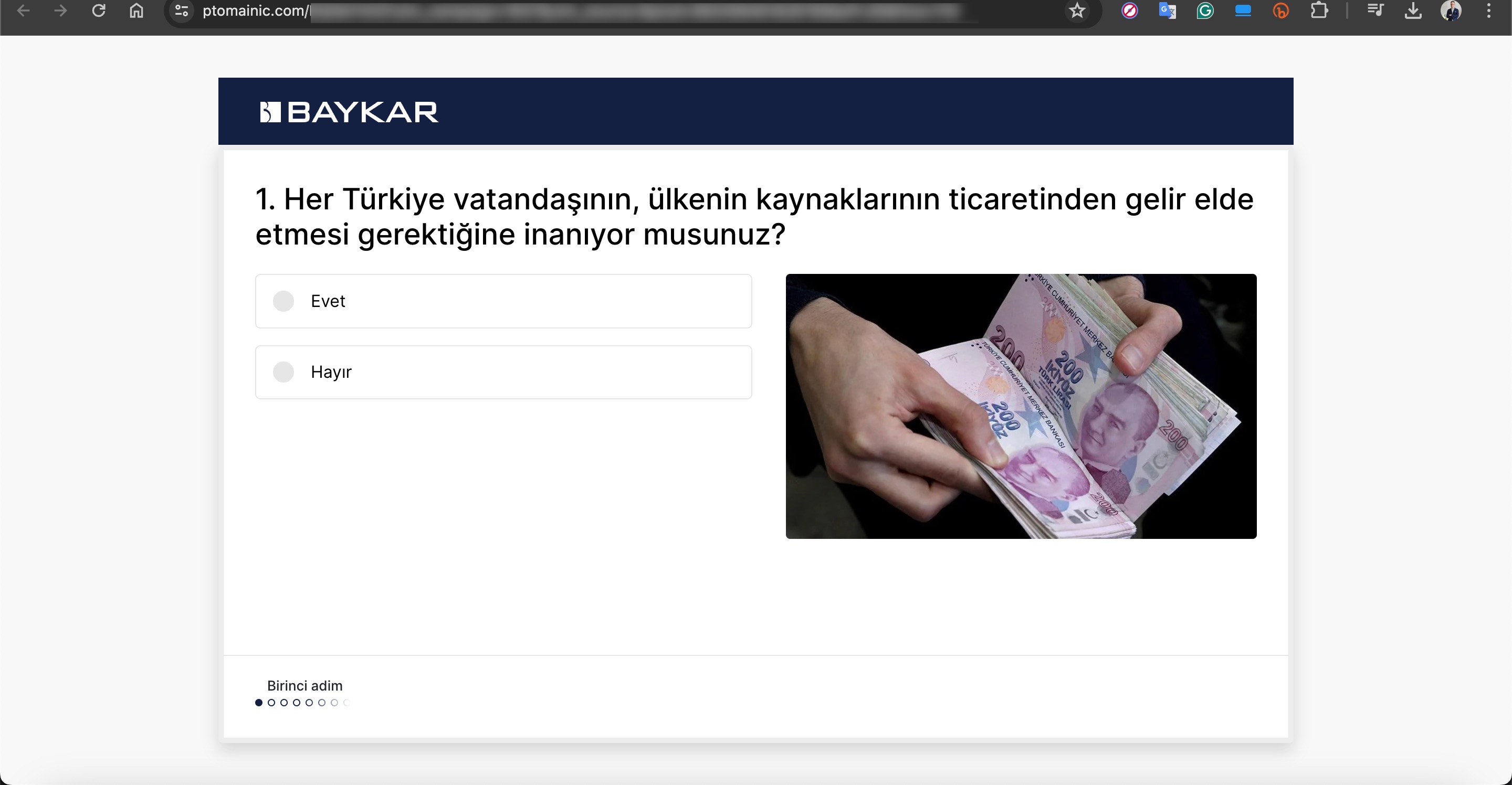

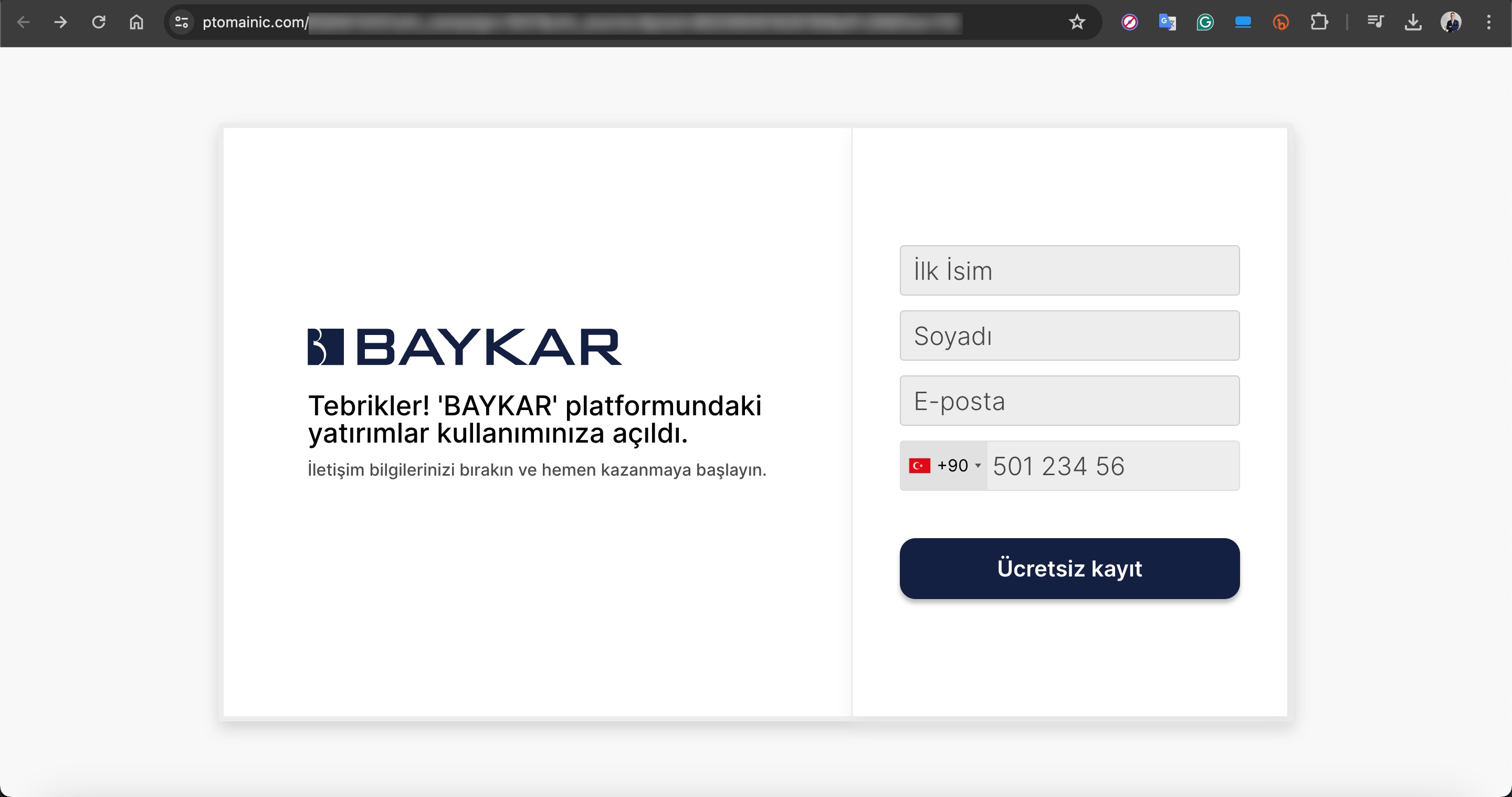

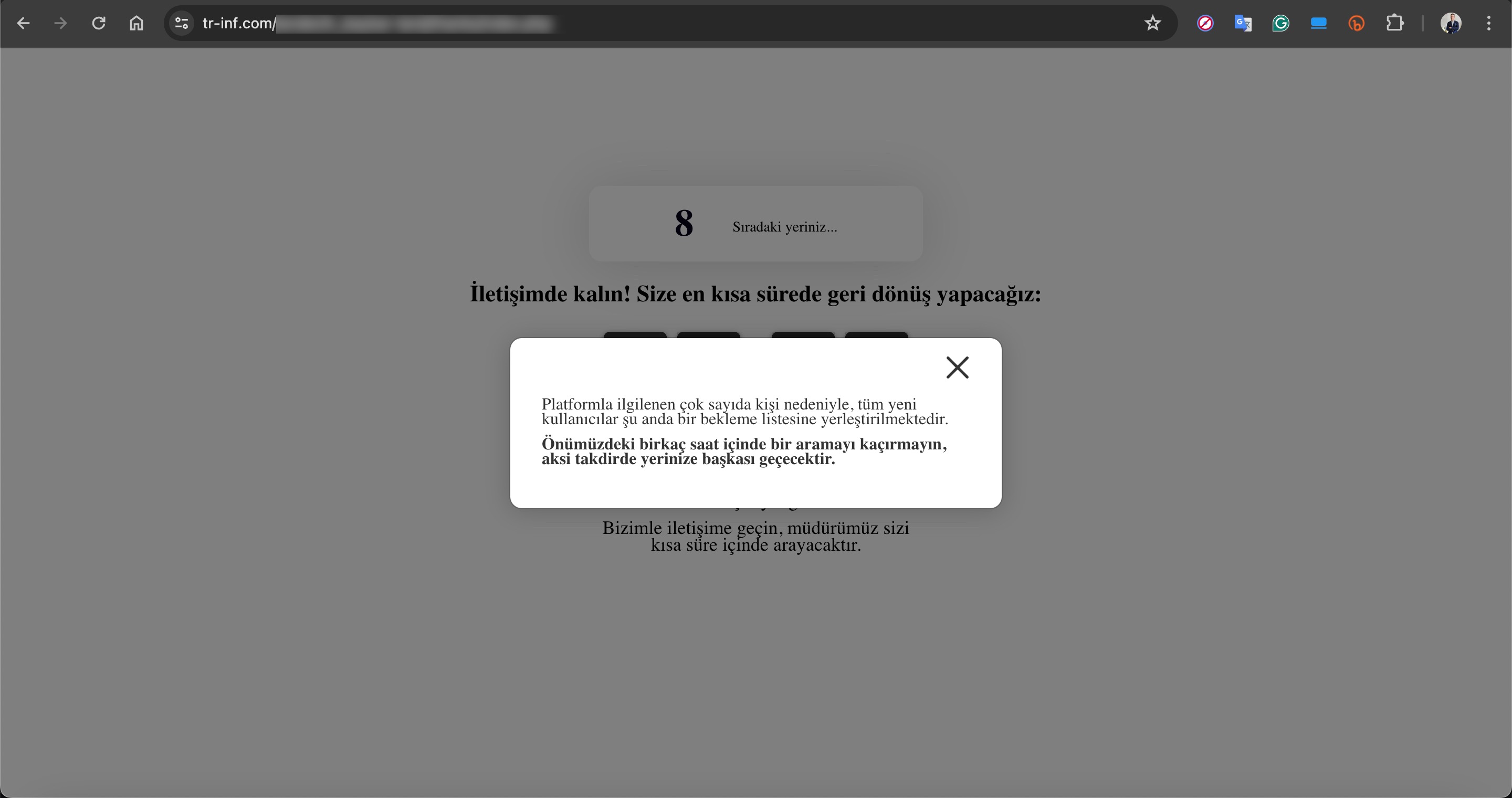

Minimum 8000 TL yatırım ile ayda 100.000 TL kazanç elde edilebileceğinin vaad edildiği sahte, deepfake videolarına konu olan bağlantı adresleri ziyaret edildiğinde karşınıza kimi zaman sadece isim, soyad, e-posta adresi ve cep telefonu numarasını isteyen oldukça basit kimi zaman ise görsel açıdan zengin, çoktan seçmeli seçeneklerle daha fazla bilgi toplayan ve ardından bir operatörün sizinle iletişime geçeceğini söyleyen bir başvuru formu çıkıyordu.

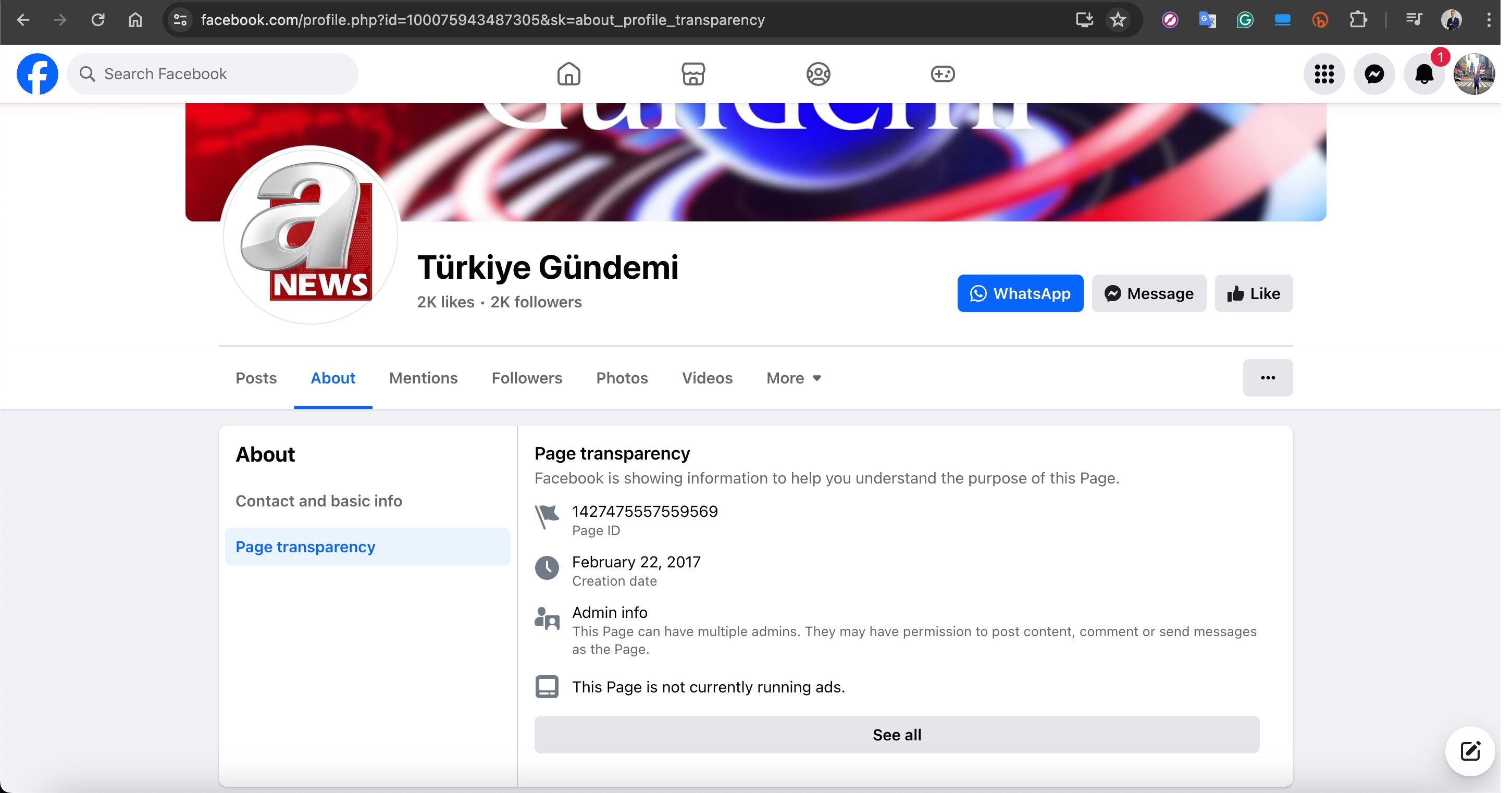

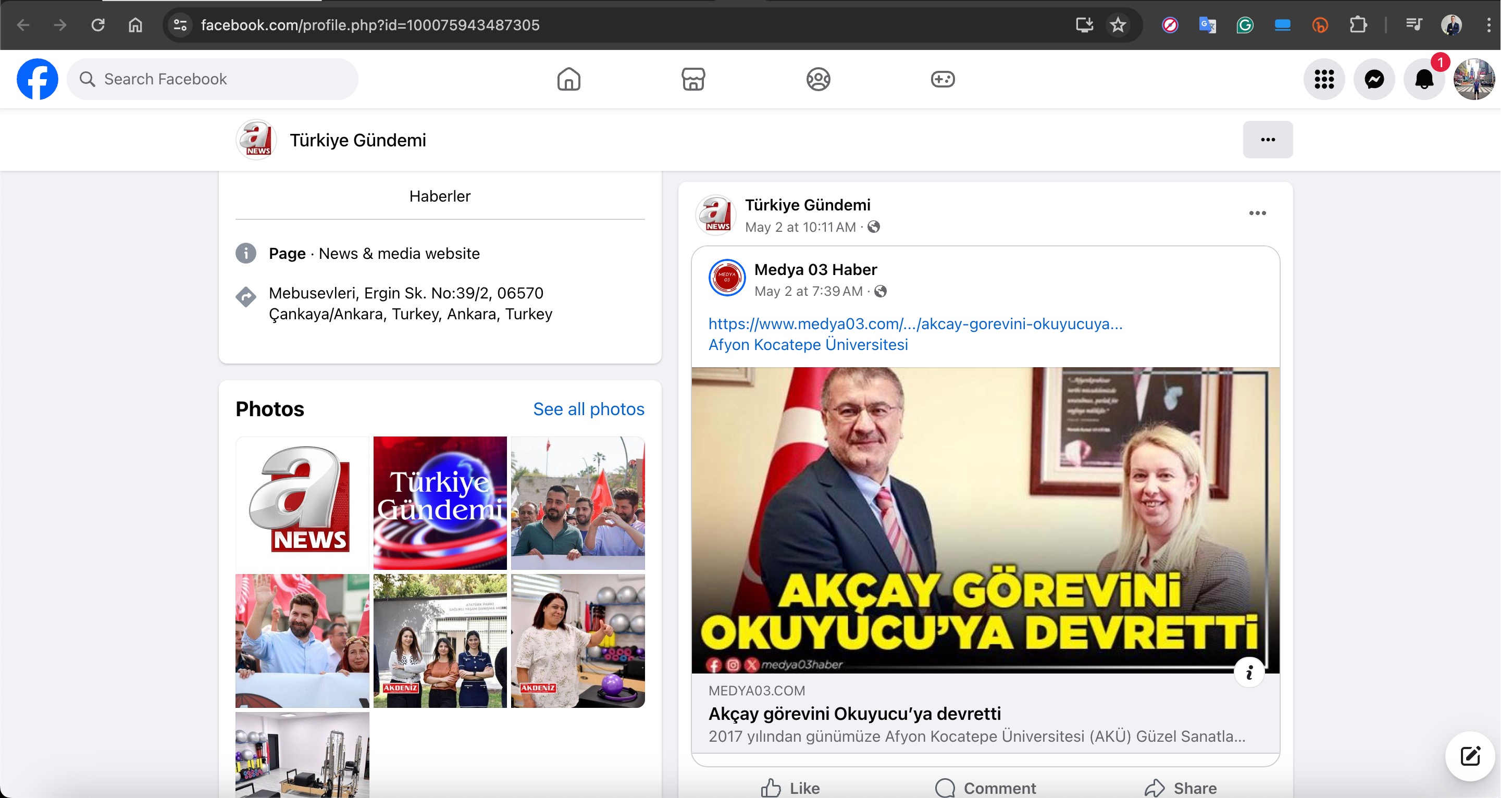

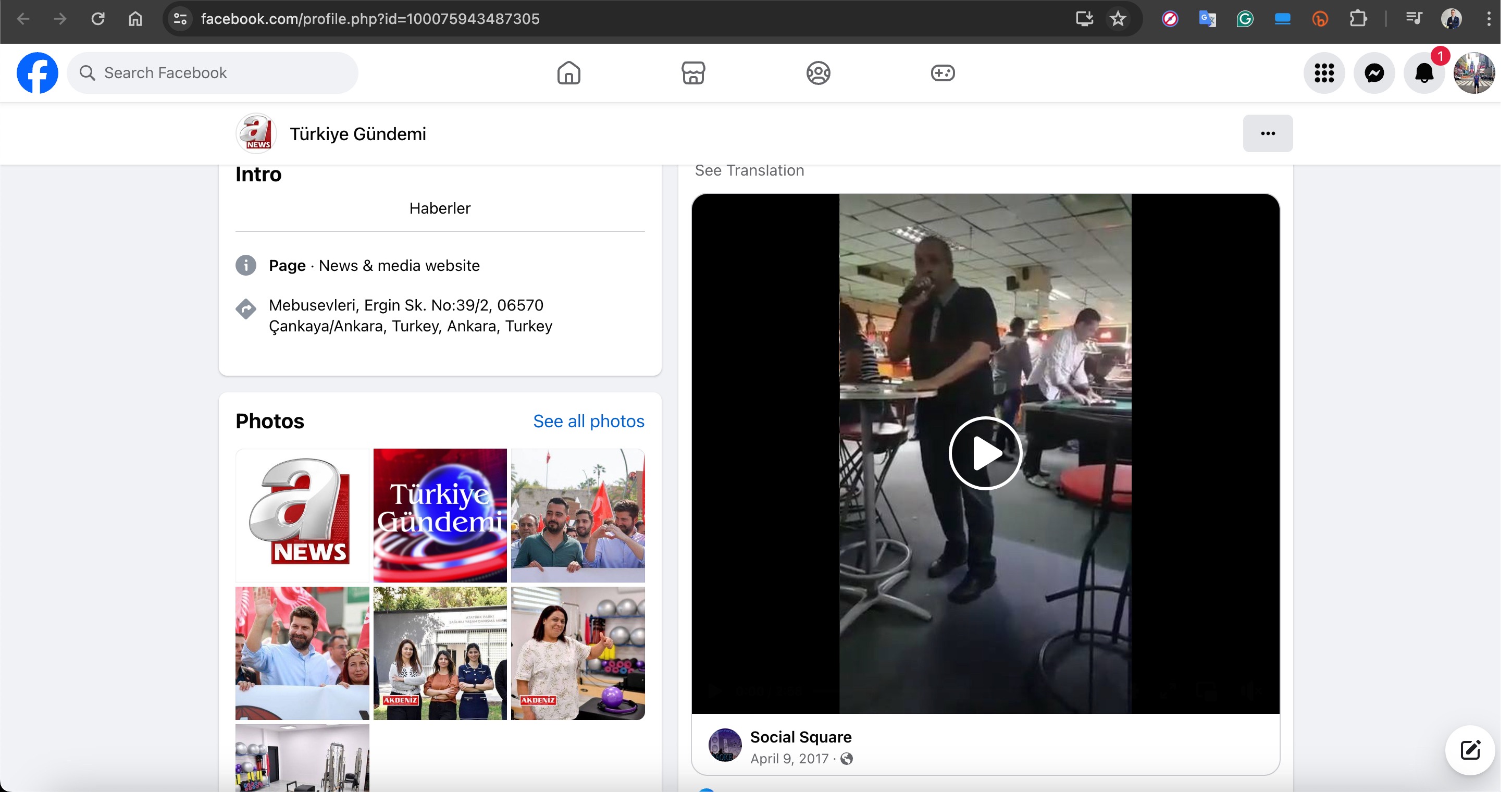

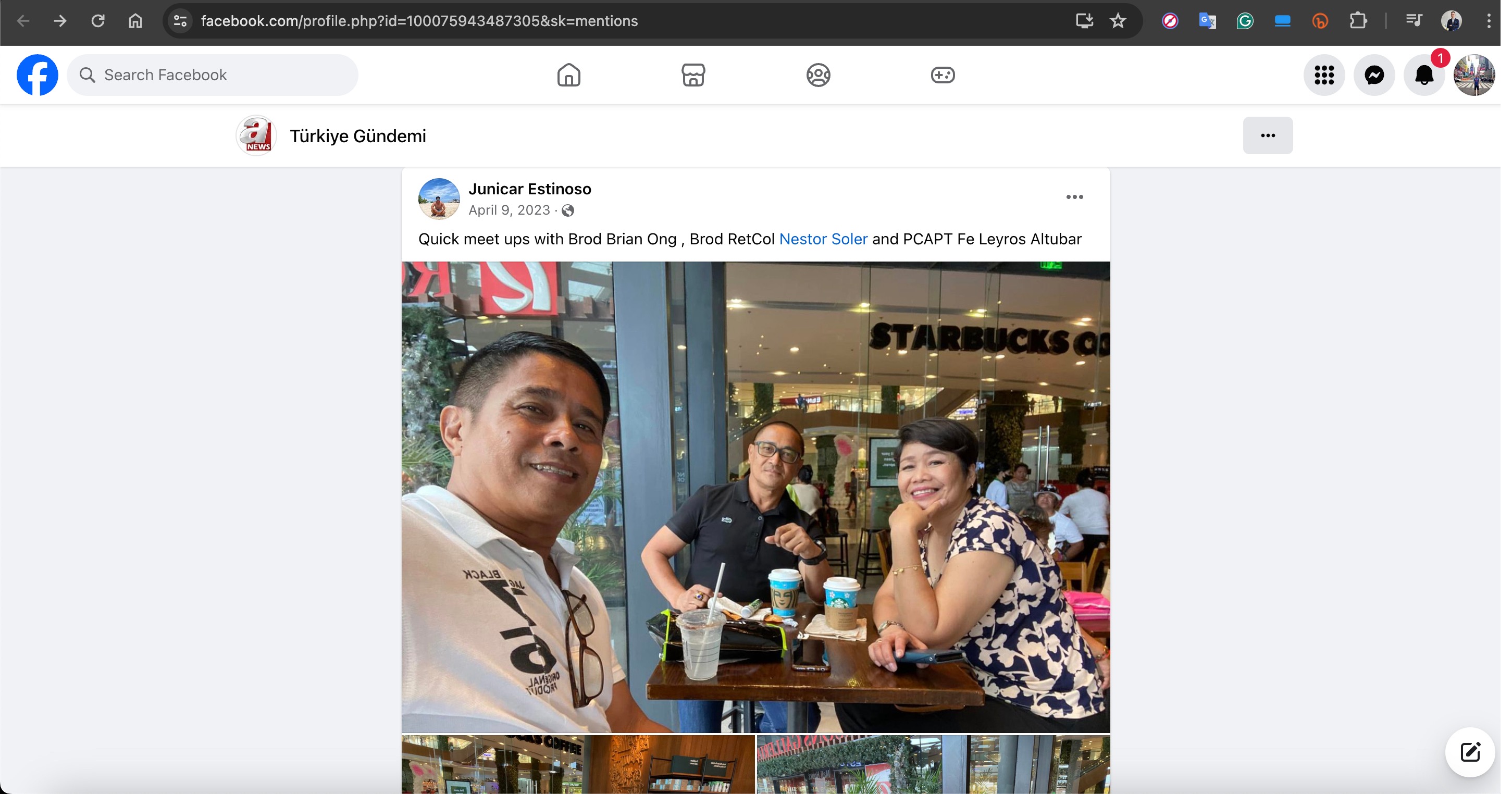

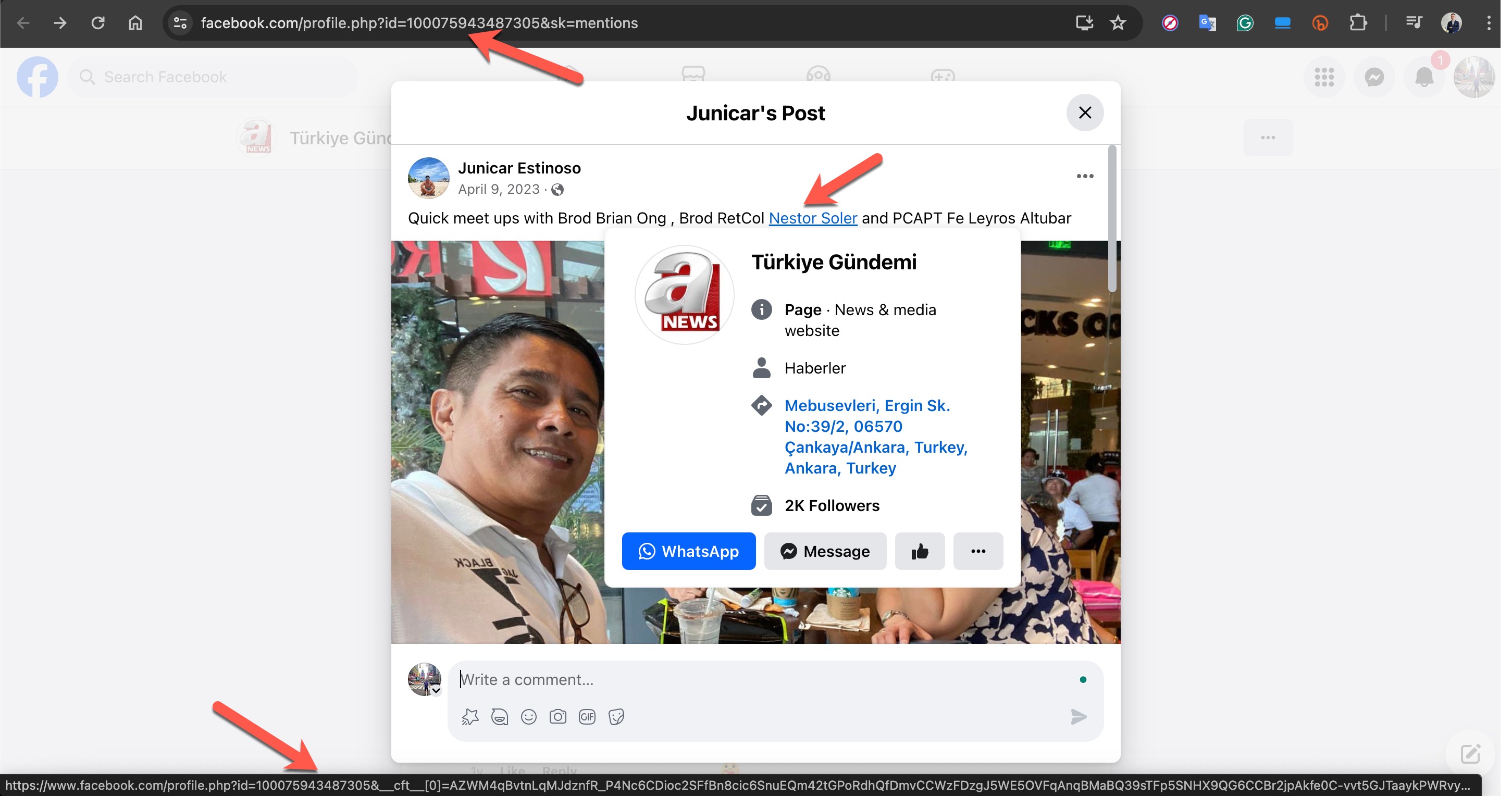

Sahte reklamlara konu olan Facebook hesaplarına bakıldığında bu hesapların kuvvetle muhtemel masum kişilere ait olup, hacklendiği ve bu amaçla kullanıldığı hesapta paylaşılan geçmiş fotoğraflara ve videolara bakıldığında kolaylıkla anlaşılıyordu.

Örneğin A News haber kanalını taklit eden, aşağıdaki ekran görüntüsünde yer alan Türkiye Gündemi isimli Facebook profilinin “Bahsetmeler” sayfası incelendiğinde aslında bu hesabın 2017 yılında oluşturulmuş Nestor Soler isimli bir kişiye ait olduğu görülüyordu.

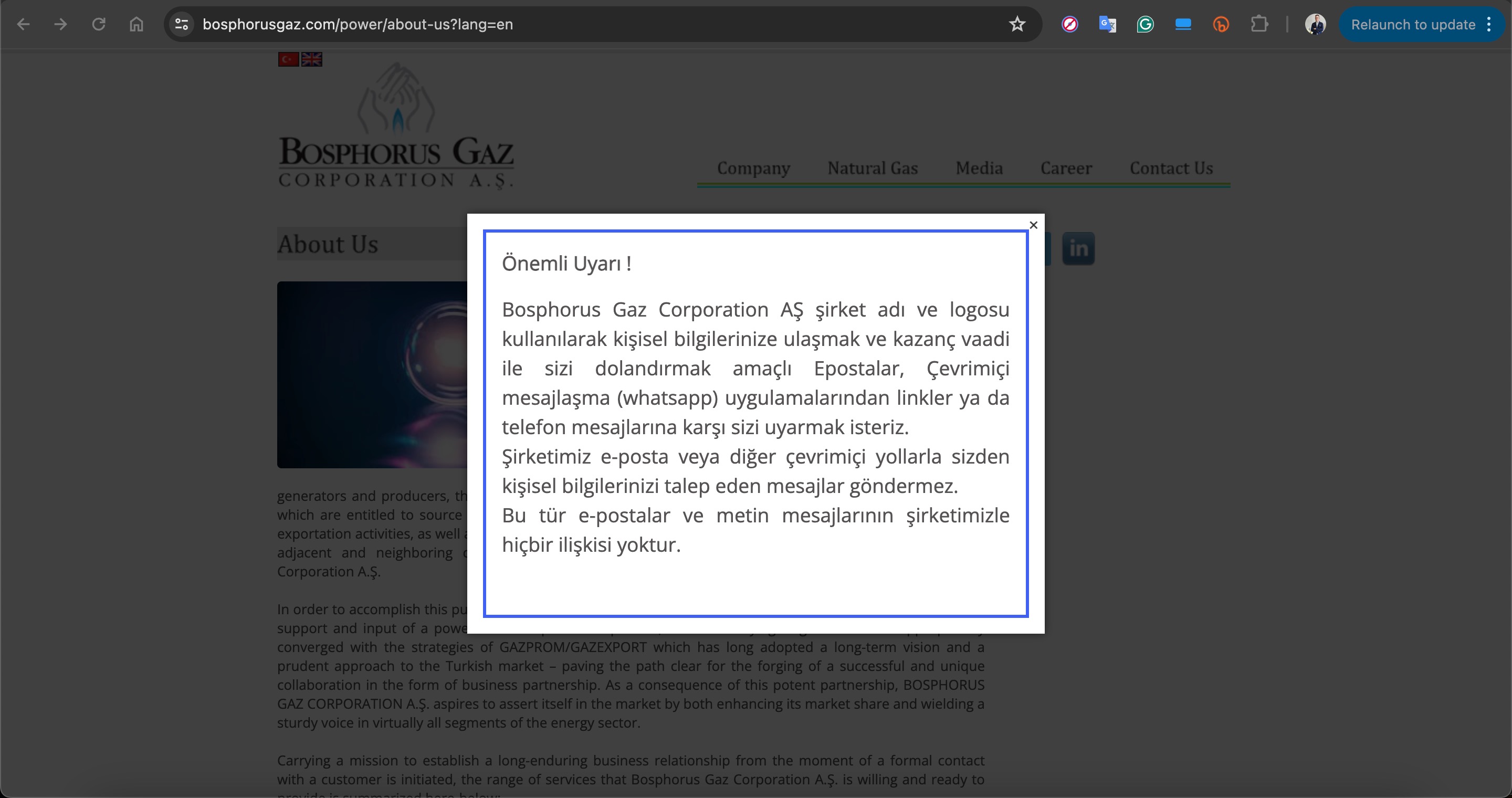

Altı ay içinde bu dolandırıcılık yöntemi ile Türkiye’de de çok sayıda kişi hedef alınmış olsa gerek ki buna karşı hem Baykar hem de Bosphorus Gaz şirketleri tarafından kamu oyu bilgilendirilmesi yapıldı.

Deepfake ile Mücadele

Peki teknolojinin son nimetlerinden faydalanılarak oluşturulan bu dolandırıcılık tezgahlarına düşmemenin her geçen gün çok daha zorlaştığı sanal dünyada, son kullanıcılar, uzmanlar, gazeteciler tarafından deepfake olduğundan şüphe duyulan videolar nasıl tespit edilebilir?

Mevzu bahis deepfake videolarını tespit etmek olduğunda diğer deepfake türlerine göre bunları tespit etmenin görece daha kolay olduğu söylenebilir. Buna yönelik olarak da akademik çalışmaların hızla devam ettiği, Intel gibi teknoloji devlerinin de bunları FakeCatcher gibi teknolojilerle hayata geçirdiği görülüyor. Özellikle kurumsal dünyaya hitap eden bu teknolojilerden faydalanmak son kullanıcılar için kimi zaman mümkün olamayacağı için, sosyal medyadan haber takip eden, internetten alışveriş yapanlar için karşılaşılan şüpheli görselleri ve videoları doğrulama ihtiyacı (günümüzde bilginin doğrulanması gibi) her geçen gün daha da önem kazanmaktadır.

Bir görselin veya videonun sahte olup olmadığını anlamak için nelere dikkat edilmesi gerekir diye uzmanlara, otoritelere kulak verildiğinde genelde aşağıdaki maddeler öne çıkmaktadır.

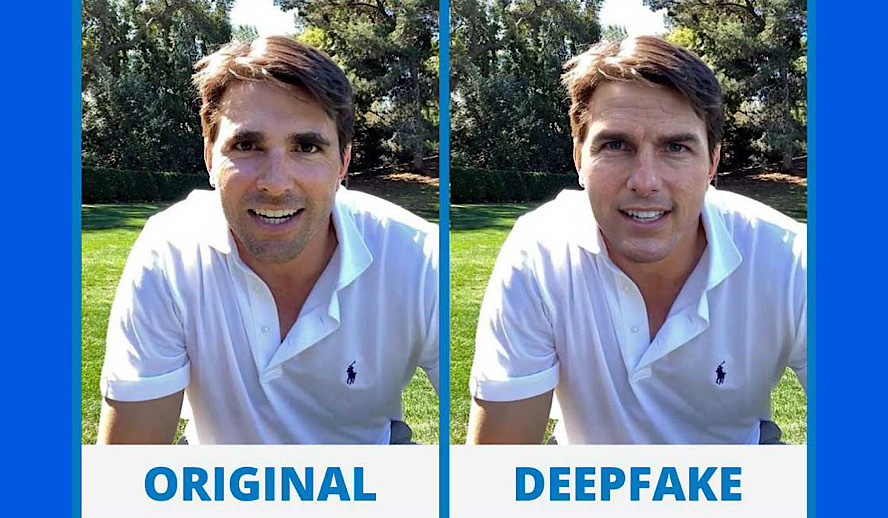

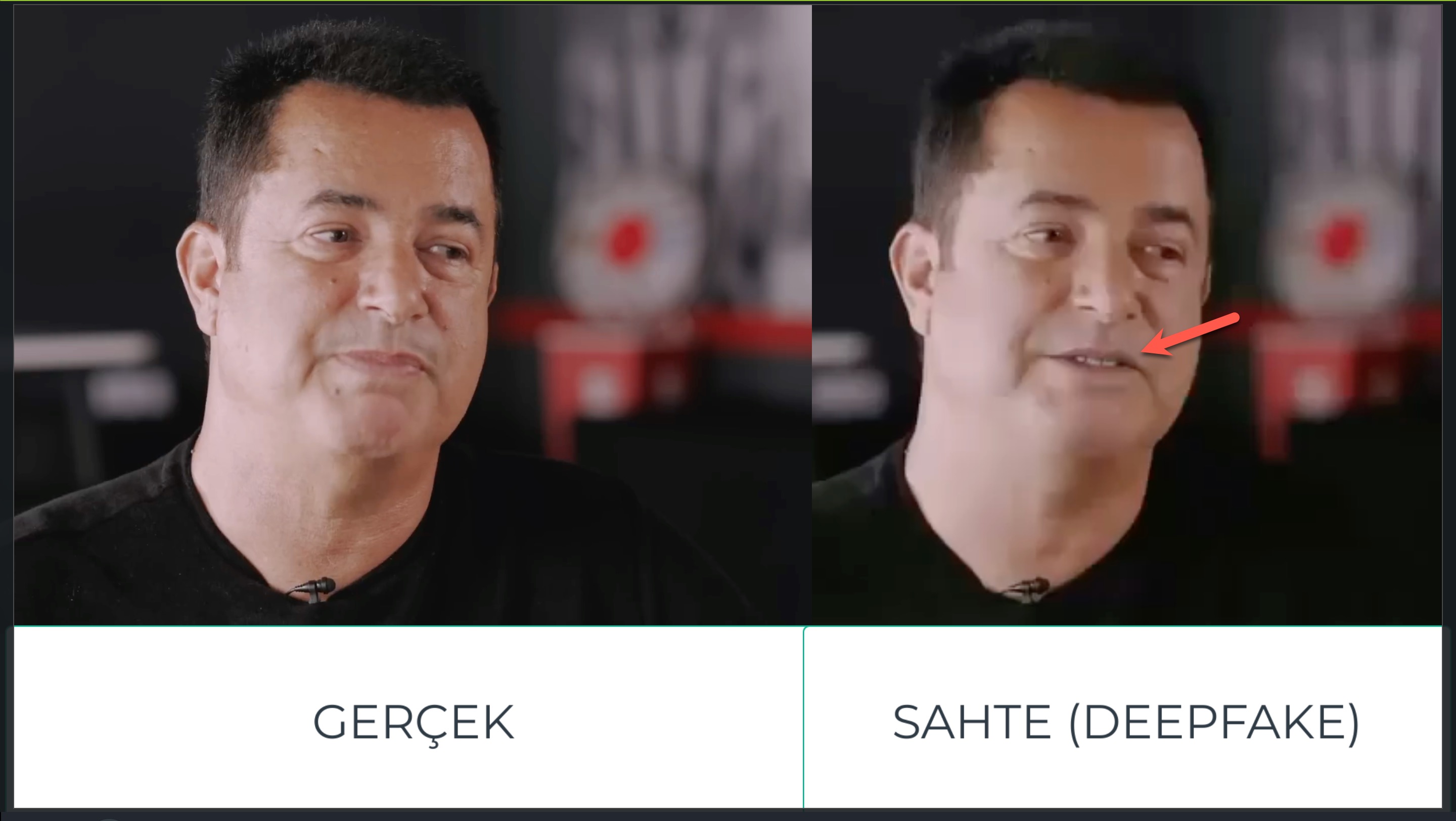

Bu öneriler gerçekten işe yarıyor mu sorusuna yanıt bulmak için ise yine dolandırıcılar tarafından hedef alınan Acun ILICALI’nın gerçek videosu ile dolandırıcılar tarafından oluşturulan sahte, deepfake videosu yan yana koyulup incelendiğinde gerçekten de ilk madde olan “belirgin bulanıklık” hemen göze çarpıyordu.

Benzer şekilde yakın çekim olan sahneler yan yana koyulduğunda ve aynı anda ilerletildiğinde özellikle ağız, mimik hareketleri ile dişlerin görünürlüğü arasındaki tutarsızlık da şüphe uyandırıyordu.

Peki bu deepfake video tespitini bizim için yapacak araçlar, uygulamalar yok mu diye soracak olursanız özellikle bilişim teknolojilerine yakın kişilerin “Deepfake detection using Deep Learning” projesine bir göz atmalarını tavsiye edebilirim.

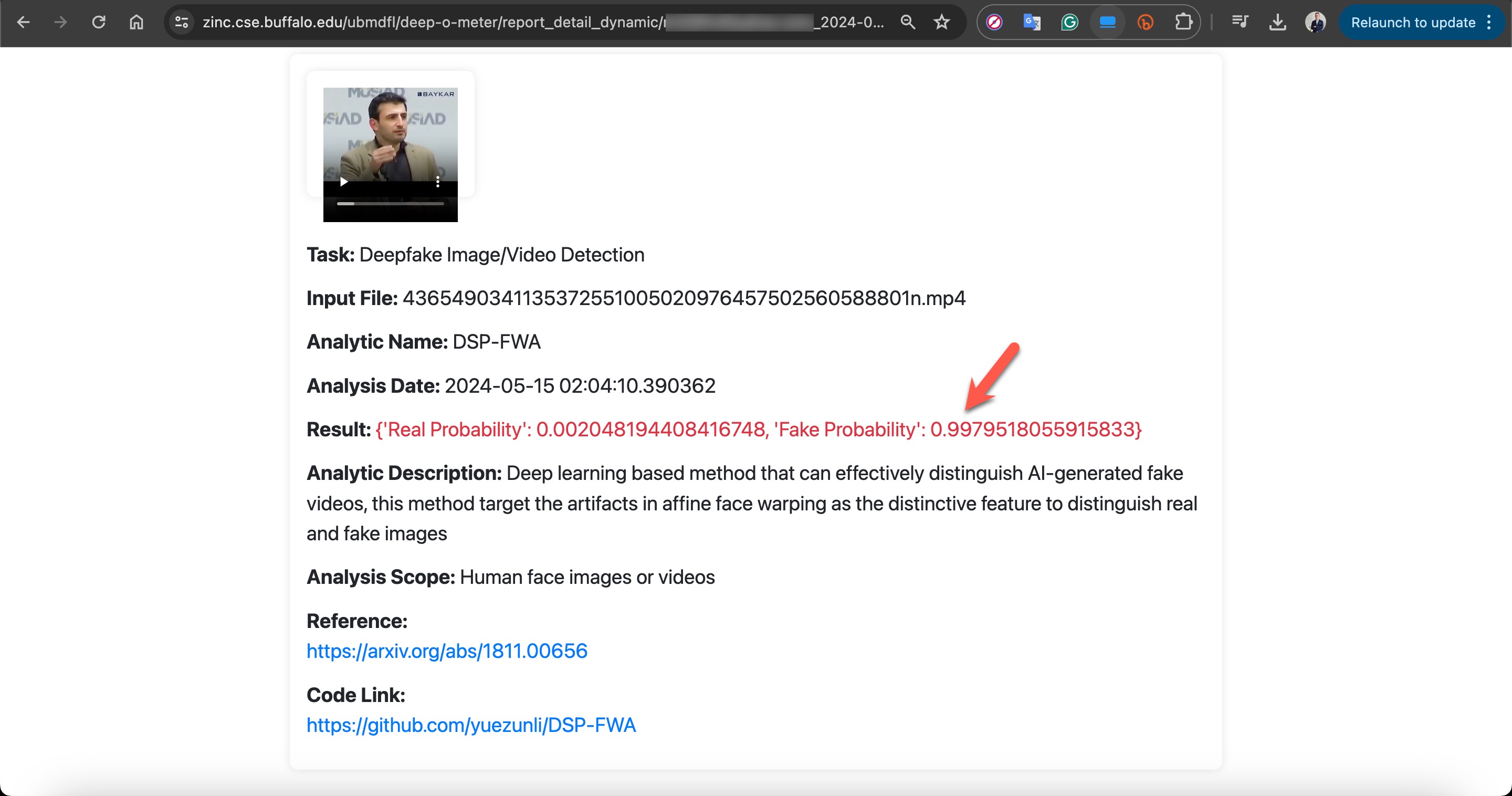

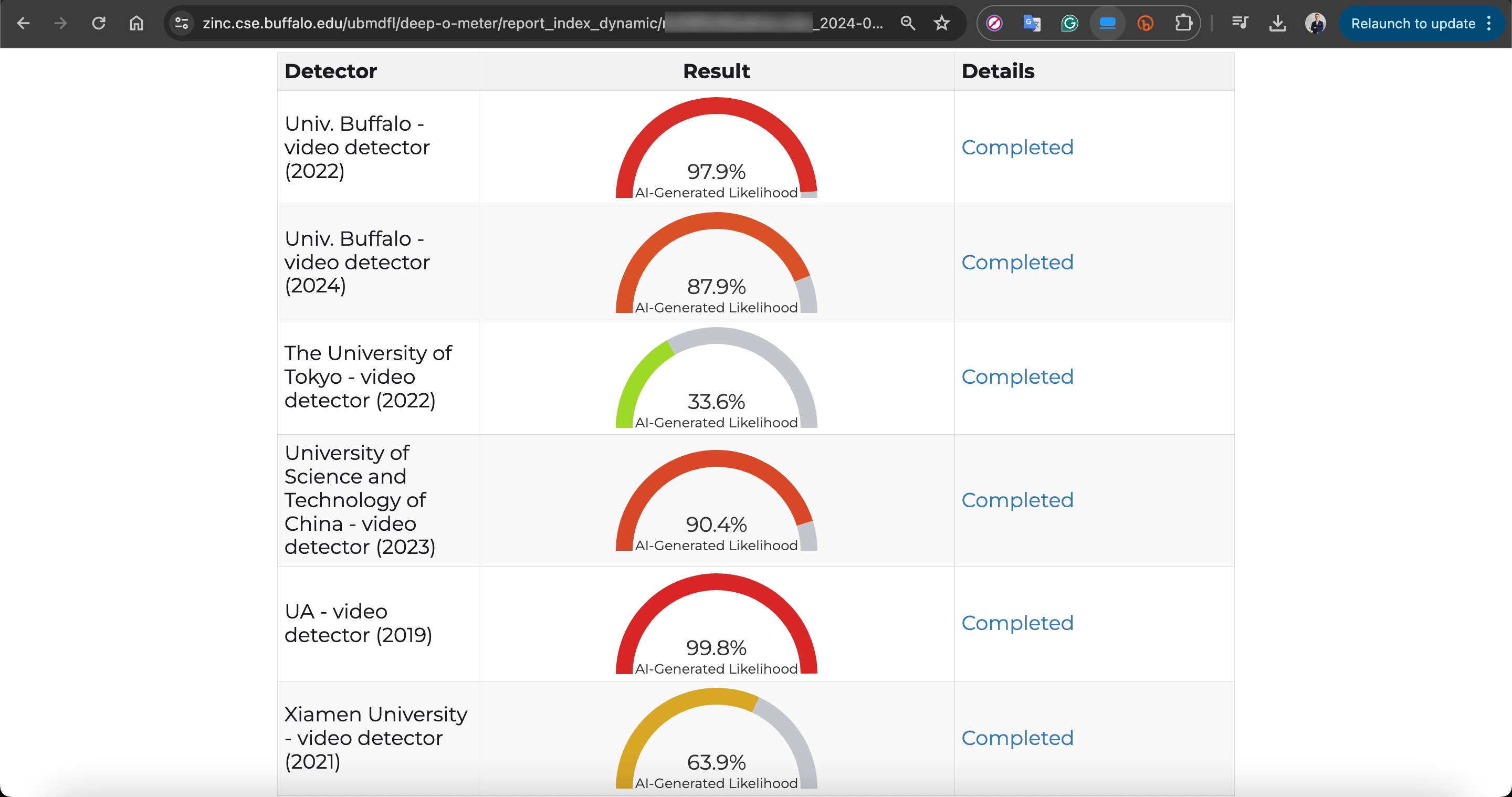

Deepfake video tespitini, çevrimiçi (online), akademik çalışmalar ışığında birden fazla deepfake tespit algoritması ile zahmetsiz ve ücretsiz olarak yapmak isteyenler için ise DeepFake-O-Meter uygulamasını şiddetle tavsiye edebilirim.

Örneğin dolandırıcıların, Selçuk BAYRAKTAR’ın bu videosundan kesitler alarak oluşturdukları bir deepfake videosunu DeepFake-O-Meter üzerinde analiz ettiğimde algoritmaların çoğu bu video ile doğru olmayan birşeyler olduğunu, şüphelenmem gerektiğini net olarak ortaya koyuyordu.

Internet tarayıcısı üzerinde bir eklenti ile bu tür deepfake görsellerini ve videolarını tespit etmek isteyenler için ise DeepfakeProof Chrome eklentisi denemeye değer olabilir.

Dolandırıcılar, Deepfake Videoları Nasıl Oluşturuyorlar?

Deepfake videolar kullanılan sahte reklamların son 6 ayda mantar gibi çoğalmasına bakıldığında bu sahte video oluşturma sürecinin dolandırıcılar için fazlasıyla kolay, bir o kadar düşük maliyetli veya ücretsiz olması gerekiyordu. Bu tezimi desteklemek için dolandırıcılar tarafından deepfake video oluşturmak amacıyla kullanılma ihtimali olan uygulamaları araştırmaya başladığımda, videonun bulanık olması, dudak senkronizasyonu (lip sync) tekniğinin kullanılması ve tabii ki açık kaynaklı ve ücretsiz olması nedeniyle oklar hemen Wav2Lip modeline çevirildi.

Wav2Lip, videolardaki dudak hareketlerini ses parçalarıyla senkronize edebilen ücretsiz, açık kaynaklı bir derin öğrenme modelidir. Herhangi bir ses, dil veya kimliğin yanı sıra sentetik sesler ve CGI yüzleriyle de çalışabilir.

Bu modelden faydalanarak dolandırıcılar tarafından hedef alınan gerçek videolardan birini, deepfake video oluşturmak amacıyla geliştirilmiş Wav2Lip_simplified_v5.ipynb isimli, ücretsiz Jupyter not defteri aracına verdiğimde, ortaya çıkan sonuç ile dolandırıcılar tarafından oluşturulan sahte, deepfake videodaki benzerlikler (dudak hareketlerinin metinden üretilen ses (audio deepfake) ile her daim senkron olamama problemi) dolandırıcıların bu modelden faydalandığı ihtimalini güçlendiriyordu.

Sonuç

Yapay zekadaki çığır açan gelişmeler bir yandan dolandırıcıların ekmeğine yağ sürmeye, işlerini kolaylaştırmaya devam ediyor. Örneğin sadece aylık 5$ ödeyerek taklit etmek istediğiniz bir kişinin video veya ses dosyasını ElevenLabs web uygulamasına yükleyerek yapay zeka sayesinde yazdığınız herhangi bir metnin bu kişi tarafından seslendirilmesini sağlayabiliyorsunuz. Durum böyle olunca da bu tür ticari girişimler her daim art niyetli kişiler tarafından kötüye kullanılma potansiyeline de sahip oluyor.

Sosyal medya ve ağlarda artan deepfake videolara karşı çok ama çok dikkatli olup yine benzer şekilde sesimizin kopyalanması (audio deepfake) ve dolandırıcılar tarafından yakınlarımıza, sevdiklerimize karşı kullanılma ihtimali olduğunu da unutmayalım. Sesinizin kopyalanması ihtimaline karşı yakınlarınızla aranızda acil durumlarda kullanılacak bir anahtar kelimeyi doğrulama amacıyla şimdiden belirlemekte de fayda olabilir.

Duyduğumuza inanamadığımız (audio deepfake), izlediğimize inanamadığımız (deepfake video), okuduğumuza inanamadığımız (yanlış bilgi, dezenformasyon, deepfake text) günümüzde, yılların klişesi olan “Gözünle görmediğin hiçbir şeye inanma.” öğütünü aklımızdan çıkarmayalım.

Bir sonraki yazıda görüşmek dileğiyle herkese güvenli günler dilerim.

2 comments

Hocam sıfırdan tersine mühendislik blogları istiyoruz.

40’ından sonra biraz zor o iş artık. :)